No início deste ano, o Facebook anunciou a criação de um órgão independente para avaliar os casos problemáticos em que as regras de moderação das suas redes sociais, Facebook e Instagram, levantam sérias dúvidas. O intuito do grupo é, juntando nomes reconhecidos da política mundial e da luta pelos direitos humanos, servir de órgão de consultoria ajudando o Facebook e os seus grupos de moderação a responder a determinadas situações.

Constituído por várias figuras independentes do FACEBOOK Inc., mas com financiamento da empresa, o “Comité de Supervisão” anunciou agora, neste início de Dezembro, os primeiros casos que tem em mãos, bem como os membros do conselho que se debruçarão sobre eles. Entre os seis casos seleccionados de um dossiê de mais de 20 mil, estão situações relacionadas com os limites da liberdade de expressão, o que é discurso de ódio, o controverso mamilo feminino, o Ministro da Propaganda de Adolf Hitler e a Covid-19, como não podia deixar de ser. Depois do anúncio da abertura de cada caso em sede de “Supervisão”, os casos ficarão 7 dias abertos para comentários públicos, num processo inédito que dá a conhecer a forma como este Comité de Supervisão – uma espécie de conselho de auto-regulação – irá funcionar no futuro.

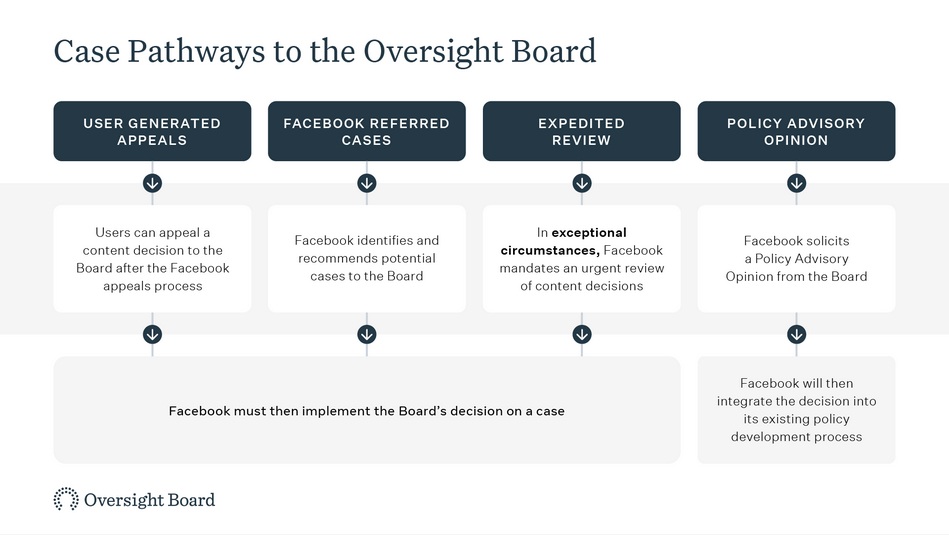

O comité pretende actuar quando todos os outros mecanismos de moderação de conteúdos nas redes sociais não funcionam, quando os utilizadores não concordam com as decisões de moderação que lhes foram aplicadas, quando o Facebook identifica a necessidade urgente de decidir sobre um conteúdo de particular relevância ou quando é necessário desenvolver políticas de moderação para novos desafios que a gestão da rede social detecte. Entre os 6 casos apresentados, 5 são referentes à primeira categoria, resultando de litígio entre utilizadores e as redes sociais e apenas 1 se deve a um pedido de aconselhamento da empresa.

Um dos casos tem a ver com a publicação de um utilizador no seu perfil de uma captura de ecrã de dois tweets do ex-Primeiro-ministro da Malásia, Mahathir bin Mohamad, nos quais se lê que “os muçulmanos têm o direito de ficar com raiva e matar milhões de franceses devido a massacres anteriores” ou que os franceses “deveriam é ensinar aos cidadãos a respeitar os sentimentos das outras pessoas”. A publicação foi removida por violar a política do Facebook sobre discurso de ódio, mas o utilizador apela que a sua partilha tinha como intuito informar os seus seguidores sobre “coisas horríveis” que o Primeiro-ministro havia dito.

O segundo caso da lista prende-se também com as diferentes interpretações que uma publicação pode ter. Nesta situação, um utilizador publicou duas fotografias bem conhecidas de uma criança refugiada síria falecida junto ao mar, para, em birmanês, questionar porque não há retaliação à China pela forma como o país trata os muçulmanos Uígur, comparando o caso com a resposta dada aos assassinatos em França relacionados com cartoons. A publicação foi removida e indiciada por discurso de ódio mas, no seu apelo, o utilizador diz que o objectivo era precisamente demonstrar discórdia perante a posição dos que consideram os crimes normais, e enfatizar que as vidas das pessoas são mais importantes do que religiões.

De Baku, no Azerbaijão, chega o terceiro caso. Um utilizador publicou fotografias alegadamente históricas onde apareciam igrejas na cidade com uma legenda referindo que Baku fora construída pelos arménios, e questionando onde estavam hoje as igrejas que lá foram construídas. A publicação referia que os arménios estão a restaurar as mesquitas por serem parte da sua história, contrastando com as mudanças que Baku, a capital do Azerbaijão, tem sofrido. Na publicação, Areg Barseghyan, o autor, usava a expressão “т.а.з.и.к.и” para se referir, na consideração dos moderadores do Facebook, de forma ofensiva, aos azeris, procurando criticá-los por terem, alegadamente, sido responsáveis pelo desaparecimento de duas igrejas de construção Arménia. Foi precisamente a expressão “т.а.з.и.к.и” que, segundo a imprensa arménia, foi considerada problemática pelos moderadores do Facebook que categorizaram a publicação como discurso de ódio – recorde-se que durante este ano Arménia e Azerbeijão estiveram em conflito armado sobre a zona de Nagorno-Karabakh. Na publicação, o utilizador dizia que os azeris não tinham qualquer história e que estavam a destruir o património arménio, demonstrando-se contra aquilo que descreveu como actos de “agressão e vandalismo” dos azerbaijanos. O caso remonta para uma complexa questão geopolítica e cultural — a maioria dos arménio é cristã, enquanto a maioria dos Azeris é muçulmana, daí a importância dada às igrejas. Curiosamente, na nota sobre o caso, a equipa do Facebook não traduz a expressão “т.а.з.и.к.и”, o que torna complicado o comentário público.

Facebook criou um conselho de auto-regulação. O que é? O que está em causa?

O quarto caso prende-se com o mamilo feminino. Um utilizador no Brasil partilhou um conjunto de imagens no Instagram onde mostrava sintomas de cancro da mama e, pelo meio, mamilos femininos. O utilizador indicou que o objectivo era consciencializar para os sintomas de cancro da mama, tendo utilizado um fundo rosa nas publicações para remeter para a campanha de prevenção do cancro, Outubro Rosa. As publicações foram, no entanto, removidas pelo Instagram por nudez.

O quinto caso prende-se com o facto de um utilizador ter feito uma re-publicação de um conteúdo que tinha partilhado dois anos antes no Facebook – uma suposta citação de Joseph Goebbels, o Ministro da Propaganda nazi de Adolf Hitler, sobre a necessidade de apelar a emoções e instintos em vez de ao intelecto, e sobre a irrelevância da verdade. O post foi removido por ter uma referência nazi, ao abrigo das regras sobre “Pessoas e Organizações Perigosas” mas no apelo feito ao Comité o autor defende que a citação tem um significado no contexto da actual presidência dos EUA de Donald Trump que, segundo refere, parece seguir um modelo fascista.

O sexto e último caso da lista tem por base um vídeo de um alegado escândalo sobre a Agence Nationale de Sécurité du Médicament (a agência francesa responsável por regulamentar produtos de saúde) ter recusado a autorização para uso de hidroxicloroquina e de azitromicina contra a Covid-19, mas autorizado a promoção de remdesivir. O utilizador critica a falta de estratégia das autoridades de saúde em França e afirma que “a cura de (Didier) Raoult” está a ser usada noutros lados para salvar vidas. O vídeo teve quase 50 mil visualizações e menos de mil partilhas. O Facebook removeu o vídeo por violar a sua política sobre “violência e incitação”, mas foi a própria equipa de gestão da Rede Social que indicou este caso para deliberação deste comité. A empresa considera que este caso exemplifica uma situação em que uma actividade online de desinformação, neste caso sobre as terapêuticas contra a Covid-19, pode representar perigo para a vidas das pessoas.

“Como o Comitê não pode analisar todas os apelos, daremos prioridade aos casos que possam afetar vários utilizadores em todo o mundo, que tenham importância crucial para o discurso público ou que levantem questões importantes em relação às políticas do Facebook”, lê-se numa nota divulgada o Comité, que tem vindo a receber apelos dos internautas que viram os seus conteúdos removidos desde Outubro. O Comité vai para já analisar os seis casos através de painéis constituídos por cinco membros, incluindo pelo menos um membro da região implicada no conteúdo. A participação do público, que pode ser feita até ao próximo dia 8 de Dezembro aqui, será tida em conta e, uma vez tomada uma decisão, o Facebook terá um prazo máximo de 90 dias para actuar e eventualmente republicar os conteúdos eliminados. “Após o Comitê deliberar sobre os casos, o Facebook deverá implementar as nossas decisões e responder publicamente a qualquer recomendação de política que o Comité fizer.”

Os seis casos lembram como é complexa a questão dos limites da liberdade de expressão e são dúbias as interpretações que uma determinada publicação online pode ter – o conteúdo não é binário e as regras escritas nos termos e condições dos serviços Facebook e Instagram podem aplicar-se à maioria das situações mas gerar indecisões em relação a casos particulares. O Oversight Board do Facebook foi anunciado numa altura em que a rede social sofria pressões sobre a neutralidade das suas decisões e surgiu como um mecanismo de auto-regulação que ainda assim valeu algumas críticas à empresa. Estes primeiros casos serão importantes para se perceber o papel e a independência deste grupo, bem como o tipo de assuntos a que se dedicarão.

Jonas Staal e Jan Fermon: “O Facebook cria uma nova forma de alienação”

You must be logged in to post a comment.