Não é preciso passar muito tempo em qualquer uma das grandes redes sociais para nos cruzarmos com utilizadores que dizem ter acentuadas quebras no alcance de determinado post. Por algum motivo, um tweet, post ou story no meio de tantos outros parece ser suprimido pelo algoritmo, apresentando níveis de alcance abaixo do expectável. O fenómeno não é novo. Mas à medida que a discussão online vai mantendo a sua preponderância na vida pública, e que a atualidade espoleta discussões globais sobre temas divisivos, vai agora retomando a sua fama.

Se fomos aprendendo ao longo dos anos a gramática da censura política, com o estudo da história e dos movimentos políticos que a impunham, no caso desta iminente forma de censura digital ainda faltam palavras para a compreender. Shadow Ban é um dos termos que mais vezes se usa para referir este fenómeno, mas apesar de a simples expressão traduzir sucintamente o que acontece, na sombra desta suspensão esconde-se um problema muito mais complexo e granular. E sem uma resolução à vista. Na verdade, o Shadow Ban, pode nem existir como algo isolado.

Como sugere a investigadora Laura Savolainen num artigo de 2022, o termo que terá sido originalmente cunhado em 2001 por moderadores do fórum Something Awful para definir uma suspensão discreta a um utilizador, é hoje altamente disputado. As principais redes sociais, como Instagram, X ou Tiktok, negam explicitamente que o façam. Mas isso não significa que o mito não tenha razão de existir. Savolainen enquadra o shadow ban como parte do que chama folclore algorítmico — isto é, como um fenómeno discursivo, mobilizador, que serviu como plataforma de consenso entre os utilizadores na tentativa de explicar uma dinâmica recorrente de que eram alvos. Assim, diz-nos, se o termo pode não servir para explicar a prática, é uma porta de entrada para o debate sobre as práticas de governação algorítmica.

Ao longo dos 20 anos, a expressão foi ganhando novas roupagens de significado com o desenvolvimento do espaço online. Se inicialmente “não tinha nada a ver com algoritmos ou moderação de conteúdo automatizada”, hoje tem tudo. E a característica que permaneceu transversal ao longo da sua história é a incerteza. Em 2024, tal como em 2001, o shadow ban pode caracterizar-se pela imposição de uma autoridade sem que o alvo dessa autoridade seja notificado. Ao contrário das ferramentas comuns de moderação de redes sociais, como a suspensão ou a remoção de um conteúdo, em que o utilizador é notificado sobre as medidas tomadas pelas plataformas, neste tipo de casos discretos permanece a dúvida sobre os motivos, mas também sobre a magnitude das ações.

Os problemas em torno de moderação de espaços online são tão antigos quanto os próprios espaços online. Desde a criação dos primeiros fóruns para discussão pública (os Bulletin Board Systems) que se procura encontrar a fórmula perfeita para manter a civilidade nas interações. Sem grande sucesso definitivo. E se por um lado não é expectável que os espaços online resolvam problemas de conflitualidade que existem independentemente do meio, a verdade é que estas lacunas óbvias não impediram estas plataformas de se tornarem centrais tanto para as democracias nacionais como para a criação de um espaço de debate global.

Financiadas por grandes investimentos de risco, aceites de modo acrítico e simplista, as redes sociais foram crescendo, e com este crescimento aumentaram exponencialmente os problemas de moderação. Em traços gerais, podemos dizer que a popularização das redes sociais fez com que crescesse a exigência para que se tornassem espaços mais civilizados, e que com isso a sua moderação se foi tornando gradualmente mais dependente de algoritmos e menos de humanos – que foram relegados às posições mais precárias destas organizações, muitas vezes trabalhando com contratos de outsourcing altamente precários. Com isto, também o paradigma habitual de moderação em resposta a denúncias e a conteúdos sinalizados foi gradualmente substituído por dinâmicas preventivas. Mecanismos algorítmicos detectam preventivamente o potencial tóxico de um conteúdo e agem antes da exposição desse conteúdo, limitando o seu alcance e o seu impacto.

As redes sociais, de um modo geral, decidem o que pode e o que não pode ser dito. Ou, melhor dizendo, o que pode e não pode ser visto. Mas não o fazem de um modo claro, como deve ser um sistema de governança, com a descrição das políticas através de leis que os utilizadores possam conhecer e contestar. Em vez disso, estas estratégias de moderação são resultado de uma complexa teia, com várias camadas, onde humanos em condições laborais precárias e algoritmos opacos governam espaços privados numa tentativa constante de seguir a lei – diferente nas centenas de jurisdições onde as redes sociais estão disponíveis. É nesta disposição ténue e frágil, que oscila entre a moderação e a censura, que emergem fenómenos dúbios e altamente penalizadores como o shadow ban.

Olhando aos exemplos individuais, a tendência pode ser para desacreditar as denúncias, apontar razões circunstanciais, subestimar o efeito global do fenómeno e a magnitude das suas consequências. Nos últimos tempos – e esquecendo todos os desastres de moderação que têm acontecido no X, antigo Twitter – um dos temas mais marcados pela suspeita do shadow ban tem sido o ataque de Israel a Gaza. Desde o reatar do conflito têm sido várias as denúncias, vindas sobretudo do lado palestiniano. E se é, na prática, impossível monitorizar todas as incidências, e perceber por que cada post teve uma má performance – é importante não esquecer que podem ser dezenas os motivos – os relatórios do passado oferecem uma imagem privilegiada sobre como funciona o mecanismo. E embora as conclusões não sejam totalmente generalizáveis, dada a especificidade cultural e política dos dois lados, a sua complexidade torna-o um excelente estudo de caso.

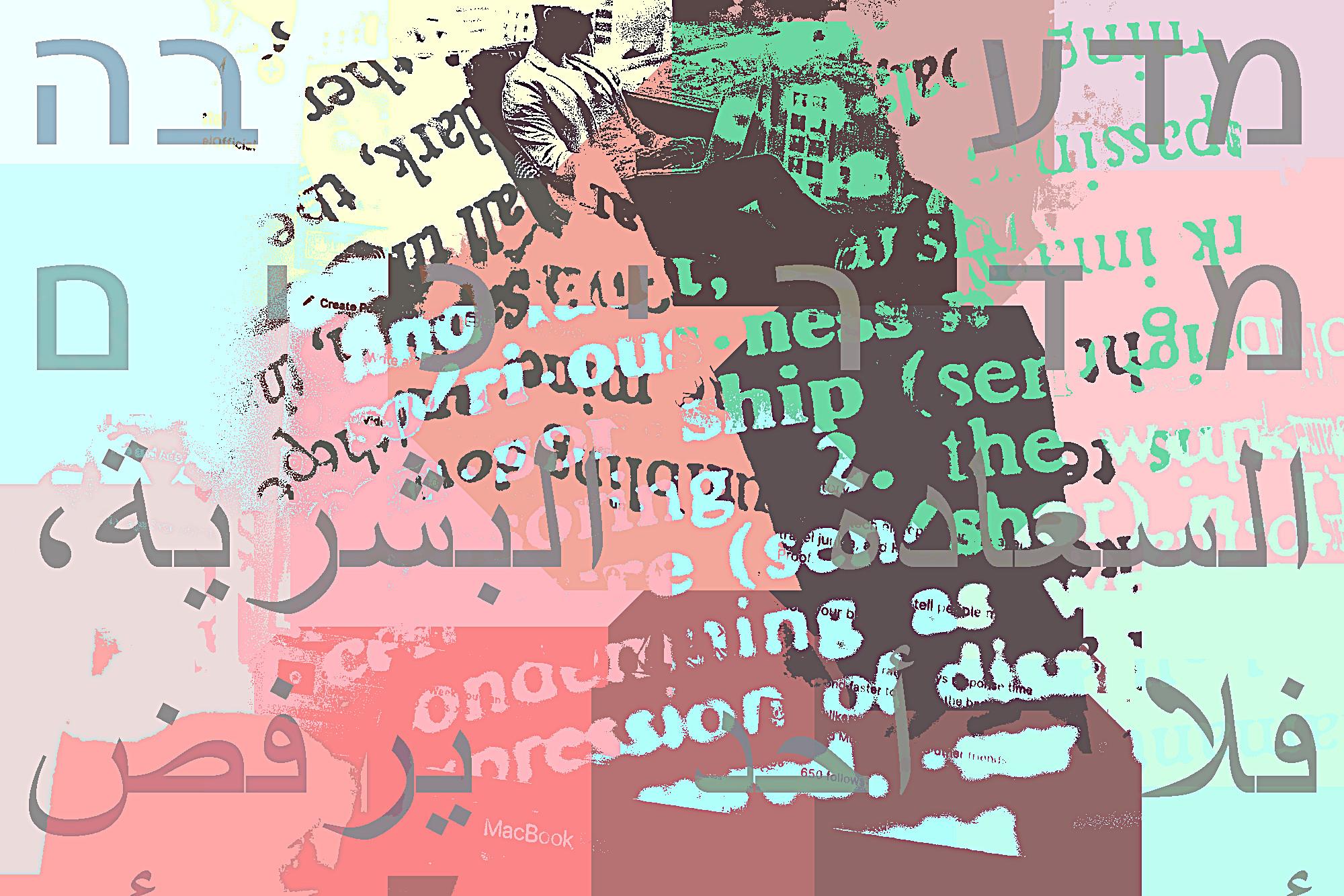

Em 2022, um relatório pedido pelo Comité de Supervisão da Meta sobre a sua actuação durante a escalada do mesmo conflito em Maio de 2021, ilustra bem as principais dinâmicas que fazem desta questão tão complexa. Com base em dados recolhidos na plataforma e entrevistas feitas neste contexto, a consultora BSR detectou acções da Meta com efeitos adversos nos direitos humanos. Em particular, a consultora reportou violações à liberdade de expressão, reunião, participação política e não discriminação dos palestinianos. Segundo o relatório, foi possível aferir uma tendência para a sobre-aplicação de medidas de conteúdos em Árabe contrastante com uma sub-aplicação de medidas em conteúdos escritos em hebreu – o que resultava em posts indevidamente apagados de um lado, e posts por apagar do outro. Um resultado explicado pela combinação de 3 grandes fatores altamente interdependentes e relacionados. O enquadramento político-legal, o optimismo tecnológico e a precariedade humana.

Com sede nos Estados Unidos da América, a Meta, detentora de Facebook, Instagram e Whatsapp, é obrigada a reger-se pelas leis deste país, que, entre outras coisas, implica a subscrição da lista do que são consideradas “organizações estrangeiras terroristas”. Nesse sentido, dado que o Hamas faz parte dessa lista, e uma vez que é a entidade que governa Gaza desde 2007, a base legal em que se concebe a moderação desta rede social começa logo à partida por deixar mais vulneráveis os palestinianos que não podem, por exemplo, expressar qualquer tipo de apoio ou elogio à entidade que os governa – seja qual for o contexto ou circunstância. Uma vez que as leis dos Estados Unidos da América neste domínio são claras e sem espaço para excepções, eliminar qualquer referência a organizações terroristas tornou-se uma prioridade para as redes sociais nestes domínios. Com isso, este tipo de obrigação legal passou a ser a base sob a qual se ergueram todos os sistemas tecnológicos. E isso ajuda a explicar as assimetrias nessa segunda camada, tecnológica.

Segundo o que foi possível aferir pela consultora, havia uma clara diferença entre os sistemas de moderação em vigor para o árabe em comparação com o hebreu. No caso, percebeu-se que para análise do conteúdo em árabe estavam em vigor um género de algoritmos de Inteligência Artificial, denominados classifiers – que são responsáveis pela deteção de conteúdo que potencialmente viole as normas das redes sociais. Algo que não acontecia no caso do hebreu. E se isso ajuda a explicar a tendência de sobre-aplicação num caso, e de sub-aplicação noutro, também demonstra cabalmente que as soluções tecnológicas para este tipo de problemas não raras vezes acabam por tornar os problemas ainda mais graves. Isto porque, apesar do marketing em torno da sua hipotética inteligência, estes algoritmos não fazem mais do que detectar padrões de potenciais violações – com base nos dados de treino, resultado de processos de moderação anteriores (e portanto parte do mesmo problema), de forma puramente tecnológica e sujeita às tão badaladas alucinações, e sem um processo rigoroso que garanta a sua adequação aos contextos locais.

Um exemplo paradigmático chegou às notícias em 2021. Quando uma equipa de moderadores sub-contratadas pela Meta procurava adicionar a Brigada Al Aqsa à lista das organizações consideradas terroristas pelos EUA e cuja propagação online deve ser mitigada. A acção teve como efeito colateral o desaparecimento de qualquer referência a #AlAqsa, uma hashtag que estava na realidade a ser utilizada para se referir a um dos sítios mais sagrados do Islão, a Mesquita de Al Aqsa, e não a brigada. Um caso em que, claramente, faltou uma adaptação do termo à realidade localidade e que pode ser explicado de várias formas.

A consultora BSR aponta como uma das possíveis explicações o facto de, sendo o árabe uma língua rica falada em vários países, as equipas de moderação sub-contratadas não terem conhecimento suficiente sobre as especificidades do povo palestiniano – nomeadamente a importância de Al Aqsa. Mas vai mais longe, e alerta para a forma como a tecnologia pode estar afinal a perpetuar essa discriminação. Se, por um lado, a falta de recursos humanos faz com que os processos se tornem cada vez mais automáticos, por outro a crescente automatização faz com que mais decisões sejam tomadas de forma discreta e invisível, sem possível contestação. A suspensão ou eliminação de conteúdos passíveis de apelo é gradualmente substituída por uma limitação do alcance dessa mesma publicação. E o shadow ban deixa de ser um fenómeno circunstancial e circunscrito, para se tornar numa espécie de modus operandi da moderação online.

E se em função deste relatório da consultora a Meta decidiu implementar algumas das medidas recomendadas (cerca de metade), a verdade é que os dados e relatórios mais recentes mostram que o mesmo tipo de problema continua a ocorrer. No site do Comité de Supervisão da Meta vemos dois exemplos, dos dois lados do espectro. Nos dois casos, decisões da Meta inicialmente tomadas de forma automática e confirmadas por moderadores após apelo dos utilizadores, foram revogadas pelo Comité de Supervisão, o que instou a empresa a disponibilizar conteúdos que tinha apagado. Para além disso, um pouco por todas as plataformas repetem-se as denúncias do silenciamento do discurso em torno de Gaza, dezenas de associações locais e de defesa de direitos digitais escreveram um apelo às grandes tecnológicas expressando a sua preocupação, e os activistas continuam a ter de procurar, todos os dias, vias alternativas de mencionar o tema sem penalizar a sua reputação digital, tentando fintar o algoritmo.

Afinal de contas, como diz o activista libanês Toufic Braidi, pelo menos estas plataformas permitem-lhe dizer o que quer, mesmo numa altura em que nenhum órgão de comunicação social mainstream o permitiria, algo que vê como uma óbvia conquista.

Se a especificidade do exemplo palestiniano, pelo contexto de conflito e pela divisão tão acentuada entre duas línguas e culturas, e pela relação com o contexto geopolítico e legal, como dissémos anteriormente, não permite uma generalização total das conclusões, permite-nos perceber a disposição das camadas de moderação que estão vigor. E as maiores falências e paradoxos deste sistema de moderação no seu todo. Mais do que aferir a intencionalidade de cada um dos agentes, algo sempre difícil, vale a pena olhar para a disposição das camadas e a forma como deixam mais vulneráveis determinados grupos. Afinal de contas, os mesmos meios que servem para moderar todo o discurso que se gera em torno da guerra – um pouco por todo o globo – são aplicados para moderar diariamente todo o discurso que passa pelas redes sociais.

As redes sociais, na mesma medida que criaram espaços de discussão tornaram-se num intermediário privilegiado a uma escala inimaginável. Para se ter uma ideia, entre os três principais serviços da Meta – Facebook, Instagram e Whatsapp – dividem-se cerca de 3 mil milhões de utilizadores. Criar processos, infraestruturas e equipas para governar tal universo é uma tarefa sem fim à vista. E com processos bastante opacos e difíceis de regular, que moldam as regras do debate nas redes sociais, o que podemos ou não dizer e sobretudo do que devemos ou não ver.

Em 2021, a Meta anunciou o lançamento de um sistema de Inteligência Artificial multi-língua marcando simbolicamente o início de uma nova era na moderação de conteúdos. Ainda antes do fervor do ChatGPT, os grandes modelos de linguagem entraram no nosso quotidiano na primeira linha da gestão das redes sociais sem que tenhamos dado grande conta. O sistema foi anunciado pela Meta como tendo duas novidades fundamentais. Não só teria uma capacidade de rápida adaptação a novas ameaças – através de um treino (não supervisionado) em material sinalizado e noutro material que fosse recolhendo da rede. Como teria a capacidade de perceber o contexto de cada incidência. Duas características que ao longo dos últimos anos já se vinham anunciando e que refletem dois dos grandes atributos com que tem sido promovida a Inteligência Artificial. A crença na capacidade da inteligência artificial de intermediar relações sociais, percebendo todo o contexto e adaptando-se à mesma velocidade que evoluem as ameaças, tornou-se a principal bandeira de uma nova era da moderação. Com mais Inteligência Artificial e menos inteligência humana.

Outra “era” na moderação das redes sociais foi anunciada pela Comissão Europeia com o Digital Services Act, o grande pacote legislativo com o objectivo de criar um espaço digital seguro e protector dos direitos fundamentais de todos os utilizadores. Com esta mudança, que foi alvo de muita discussão mas acabou por passar com distinção e até elogios de algumas associações de direitos digitais, as grandes plataformas passaram a ter obrigações superiores de transparência e de reporte sobre as suas políticas. Apesar de a lei só ter entrado por completo em vigor em 2024, em 2023 foram publicados os primeiros relatórios de transparência a que as grandes plataformas estão obrigadas, permitindo perceber em traços largos o que representará o cumprimento desta lei.

Com os primeiros relatórios das grandes plataformas pudemos finalmente saber com rigor quantos utilizadores têm mensalmente activos mas, mais importante que isso, quantos moderadores humanos existem para cada utilizador e para cada língua representada no espaço europeu. Segundo uma análise dos dados publicada pela Global Witness, em Novembro de 2023, existe uma clara preferência pela língua inglesa, e uma flagrante negligência no que toca às restantes línguas. No panorama geral das grandes plataformas, escasseiam moderadores não só de línguas pouco faladas globalmente, mas também de outras que são globais como o francês, espanhol ou português. No caso da Meta, e no que toca ao nosso país, existem apenas 58 moderadores especializados em português para um universo de 7,6 milhões de utilizadores que se dividem pelas plataformas – um número que pode ser complementado por moderadores de outras geografias onde também se falam português, com uma perda evidente no conhecimento cultural. E do quanto fica entregue a automatismo. Como todas as línguas e dialectos minoritários que vão emergindo em sociedades cada vez mais plurais.

Sobre essa camada de governação das redes sociais, os relatórios de transparência não são tão informativos. Apesar de as tecnológicas serem obrigadas a dizer que usam tecnologias automáticas para prevenção da disseminação de conteúdo, bem como a criar bases de dados de todas as incidências em que há supressão de conteúdo, a opacidade e complexidade de todos estes processos mantém a ambiguidade como nota dominante. De resto, no texto do Digital Services Act até se podia ler uma referência directa ao shadow ban, proibindo as plataformas de fazer supressão de conteúdo baseado em keywords de forma discricionária, mas aquilo que tem sido denunciado é mais a sua normalização.

Embora as plataformas não assumam a prática, e a lei a proíba, na realidade a crescente automação segue no sentido inverso. Isto porque, como refere um estudo sobre a matéria, a moderação algorítmica – apesar das promessas de melhores sistemas e mais otimizados – resulta sempre num aumento da opacidade sobre os processo, da dificuldade da sua compreensão e no ofuscar a natureza política das decisões sobre linguagem — tapando com um véu de falsa neutralidade um dos maiores campos de disputa política da contemporaneidade (algo que de resto é reconhecido num extenso estudo sobre moderação a pedido do Parlamento Europeu).

Por fim, ainda que as plataformas, nomeadamente a Meta e a Google, disponibilizem de forma aberta os grandes modelos de linguagem para fins de investigação, a sua natureza impede um escrutínio completo. Por um lado, as plataformas dizem sempre que os modelos utilizados nas suas aplicações são versões otimizadas do que disponibilizam, sem que conheçamos ou saibamos de que se tratam essas otimizações. E por outro, porque como vimos nos sucessivos casos associados ao ChatGPT auscultar estes modelos é uma tarefa condenada ao insucesso se não for feita desde a sua concepção, garantindo um treino dos dados equitativo, a mitigação de vieses tanto quanto possível, e um processo democrático e plural de o fazer.

Os efeitos dos algoritmos nas pessoas, grupos e comunidades não é de deteção fácil e, talvez por isso, se mantenha um debate de especialidade. Mas a verdade é que estudos mostram como os algoritmos tendem a marginalizar ainda mais comunidades marginalizadas, limitando alguns dos seus direitos fundamentais. Num exemplo citado pela Agência Europeia para os Direitos Fundamentais refere-se que muitas vezes o conteúdo é sinalizado como agressivo ou de ódio quando, na verdade, é precisamente o contrário. Se em comunidades marginalizadas a linguagem é muitas vezes reapropriada e ressignificada como um importante método de emancipação, a incapacidade dos algoritmos perceber e lidar com essas subtilezas torna-os numa arma de manutenção do statu quo. O mesmo acontece por exemplo quando jornalistas tentam corrigir informações falsas ou falar de assuntos sensíveis, sendo muitas vezes alvo da mesma falta de entendimento do contexto e de perda na tradução.

Resolver este problema não é fácil. E demasiada vontade pode trazer efeitos adversos — como revelam estas estratégias mais punitivas e que condenam à falta de alcance quem use as keywords ou as expressões sinalizadas. Mas todos os relatórios e estudos convergem na mesma direção quando chega a hora de falar de soluções. Não só contratar mais moderadores humanos é uma das formas mais recomendadas de abordar o problema, como melhorar as condições em que estes trabalham e a sua formação são apresentados como pontos fundamentais. Neste domínio vale a pena olhar para o caso das redes descentralizadas como o Mastodon. Nestas, dada a sua natureza, o rácio entre moderadores e utilizadores acabam por ser muito mais próximo, e um utilizador descontente com as estratégias de moderação pode sempre escolher outro servidor onde se fazer ouvir.

Sem cair em demasia na tentação da falsa equivalência entre as duas formas de supressão da liberdade de expressão: se a censura política é institucional, e com motivações políticas mais claras, esta censura digital é discreta, e nem sempre se rege por uma agenda expressa, o que dificulta a sua problematização. Certo é que sem sinais de abrandamento para a transição dos debates para o espaço das redes sociais – dos mais globais aos mais locais – a preponderância da moderação digital vai ser cada vez maior. E nesse sentido, democraticamente, devemos perguntar-nos por quanto tempo queremos que o espaço público seja moderado por trabalhadores precários e algoritmos opacos nas mãos de empresas privadas com fins lucrativos?

O João Gabriel Ribeiro é co-fundador e editor do Shifter. É auto-didacta obsessivo e procura as raízes de temas de interesse como design, tecnologia e novos media.

Ver todos os artigosApoia a partir de 2€/mês, recebe uma newsletter exclusiva, acesso a descontos e passatempos, e contribui para mais textos como este.

Outros artigos de que podes gostar: