“A tool is but the extension of a man’s hand, and a machine is but a complex tool. And he that invents a machine augments the power of a man and the well-being of mankind.”

-Henry Ward Beecehr

Estima-se que a criação de ferramentas por hominídeos tenha, aproximadamente, 2,6 milhões de anos. O kit de Oldowan, como ficou conhecido o conjunto mais antigo, consistia em pedras que, por uma série de colisões, foram transformadas em martelos e objectos cortantes. Mais tarde, começaram a surgir indícios de machados e da utilização de outros materiais que permitiram a evolução das existências humanas. Por norma, é mais fácil encontrar vestígios arqueológicos de ferramentas do que dos hominídeos que as usavam.

A vida como ela era é-nos revelada como sequência de funções desempenhadas pelos objectos que facilitaram a concretização de determinados objectivos e, consequentemente, moldaram o mundo. Entre as principais criações destacam-se as descobertas que despoletaram processos transformadores da forma de existir e conviver, como a roda ou o telefone. É desta relação ambivalente que resulta a ideia de tecnologia, que vamos ignorando à medida que naturalizamos criações (como a roda e o telefone) e apontamos a definição àquilo que acabou de ser criado.

Avancemos um pouco. No princípio do século XX, o desenvolvimento tecnológico efervescente — marcado pela massificação da electricidade, da canalização, das vias férreas e outras tecnologias — e o avanço da cultura da ciência convergem às mãos de Frederick Winslow Taylor, criador da ideia da gestão científica conhecida como taylorismo.

Se antes uma simples artesã podia conjurar objetos a partir de algumas ferramentas, a engenheira taylorista organiza um pequeno exército de operadores de ferramentas, otimizados para produzirem eficazmente uma série de produtos. Cada trabalhador, encarregue de uma componente laboral cada vez menor, executada minuciosa e repetitivamente, começa a ver o seu trabalho medido de forma mais sistemática, tendo a eficiência como critério único: o lucro passou a ser visto como o resultado acertado de um conjunto de cálculos, e o trabalho como fonte de obtenção de lucro.

Construindo sobre esta perspectiva, o Fordismo instala-se e imobiliza o trabalho humano cada vez mais repetitivo e faz a linha de montagem girar em seu torno. O princípio da gestão científica mantinha-se e a produção padronizada, que visava reduzir as falhas e aumentar os stocks, ditava a desespecialização das trabalhadoras: tarefas outrora manuais começaram a ser automatizadas por máquinas cada vez mais sofisticadas. O trabalho tornou-se mais monótono e as qualificações mais desnecessárias; a disciplina imposta pelos predicados do lucro privaram as pessoas trabalhadoras de qualquer autonomia e criatividade, levando à criação de um ambiente desumanizante onde o fantasma da automação pudesse crescer.

Passadas décadas de domínio deste modelo, a sua falência começou a sentir-se com a subida do preço de matérias primas e a abertura à concorrência global. Consequentemente, surgiram outras propostas de organização industrial. O Toyotismo tornou-se um dos mais populares ao quebrar o imperativo da linha de montagem para ajustar a oferta à procura: o foco passa da maximização da produção para a minimização do desperdício, maximização da qualidade e garantia da ajustabilidade do processo industrial.

Se o Fordismo consagrou a massificação da produção, o Toyotismo representa a sua flexibilização. O desenvolvimento tecnológico que levantava o fantasma da automação desdobrava-se num complexo industrial com uma capacidade de gerar produtos diferenciados — o papel da trabalhadora não foi substancialmente melhorado, mas também não foi substituído. Sob o Toyotismo, as máquinas, encarregues da deteção de defeitos, paravam a produção quando alguma anomalia na produção era detectada, ficando reservada às trabalhadoras o dever de remediar e prevenir esses problemas.

Ao longo do tempo, ferramentas semelhantes foram assimiladas de diversas formas e os seus efeitos no tecido laboral foram altamente dependentes da forma como todo este complexo se organiza. Se o desenvolvimento de novas tecnologias serve o propósito de responder às necessidades e concretizar os objetivos percebidos em cada momento, é a ordem social que determina as prioridades desse momento.

Como vimos, as tecnologias e a sua utilização são condicionadas não só pelas suas capacidades intrínsecas mas também pelo seu meio envolvente. Em qualquer um dos casos, a trabalhadora vê o seu papel radicalmente alterado com cada iteração — a vigilância que nasce com o taylorismo e que é simplificada com a imobilização da massa laboral no Fordismo é automatizada computacionalmente com o Toyotismo.

Em paralelo com estas sucessivas mudanças nas últimas décadas do século passado, o trabalho físico deixou de representar a principal fonte de valor. O trabalho intelectual, principalmente nos sectores dos serviços, começou a ganhar cada vez mais preponderância (alguém tem de desenvolver novos métodos de automação e vigilância) e o computador deixou de servir apenas a fábrica para se tornar num objecto pessoal e profissional, numa autêntica indústria. As tecnologias de informação e as empresas que as comercializam reclamaram o trono das sociedades contemporâneas. A tecnologia pode ter sido democratizada, mas a capacidade de ditar o seu rumo concentrou-se cada vez mais no topo.

Poderíamos continuar a contar a história da humanidade através das suas ferramentas e daquilo que elas permitiram. Mas seria negligente — as ferramentas nunca existiram num vácuo, e são apenas a materialização inorgânica da história do complexo industrial que as instrumentalizou. As tecnologias podem ter-nos dado, em tempos, maior liberdade. Contudo, parecem agora responsáveis por nos prender a uma realidade que cada vez mais parece imutável. E se antes a tecnologia nos tornava cada vez mais capazes, o retorno do fantasma da automação faz-nos sentir novamente impotentes.

“To put it simply: the content of technology is labour; the form of technology is capital.

— “Capital is Dead: Is This Something Worse?” (2019), McKenzie Wark

A Inteligência Artificial (I.A.), como hoje é debatida num entendimento vulgar, não é o princípio de uma revolução, mas o resultado de processos de desenvolvimento tanto tecnológico como social, económico e político. Reflecte, quase na perfeição, os contextos em que foi evoluindo. A possibilidade de os computadores poderem pensar e tornar-se tão ou mais inteligentes que o humano surgiu ainda antes do conceito de I.A. ser criado em 1956. Entre os vários exemplos que poderíamos dar, vale a pena falar do caso de Eliza como um dos primeiros momentos em que um grupo de profissionais temeu a sua substituição intelectual.

Criado em 1967 por um cientista de computação do MIT, Joseph Weizenbaum, este chatbot foi um dos primeiros a enganar uma quantidade considerável de pessoas. Apesar de Eliza ter uma programação relativamente simples e capacidades rudimentares (que o leitor pode experimentar aqui), Weizenbaum notou que, ao interagirem com este chatbot, muitas pessoas acreditavam que seria capaz de dominar a linguagem natural e até substituir profissionais — no caso, psiquiatras.

Anos mais tarde, o mesmo cientista escreveu sobre todo o processo, questionando os psiquiatras mais assustados por estas tecnologias: que visão teriam não só deles próprios mas também dos seus pacientes para acharem que um processador de informação tão simples poderia desempenhar as suas tarefas? É fato que os sistemas de que hoje dispomos não são assim tão simples, mas a questão de Weizenbaum continua atual.

Com o passar do tempo, a automação no sector industrial foi de certa forma compensada pelo crescimento do emprego nos sectores dos serviços, da comunicação e da informação, que parecia completamente imune à ameaça da automação. Nunca como hoje as condições foram tão favoráveis ao triunfo da narrativa de uma possível substituição do humano em funções tão díspares quanto a de professor, jornalista ou cuidador informal. Num cenário que denuncia uma fé exacerbada na tecnologia e uma visão do papel das trabalhadoras (e das pessoas em geral) cada vez mais economicista.

A massificação dos computadores e da internet, a produção e o acesso à informação tornou-se mais barata e aparentemente mais democrática. Mas não sem que estes benefícios tivessem um custo. Se a perspectiva tecnológica alimentou utópicas profecias sobre a concretização de um espaço público global — último reduto da democracia globalizada ou da globalização da democracia —, depressa se notou o seu potencial pervasivo do tecido social.

As tecnologias de informação e comunicação rapidamente deixaram de ser complementos do aparato social vigente, para se tornarem num dos maiores complexos sociais, dando início a uma nova era. Acelerou ainda mais a industrialização da cultura e a mercantilização de atividades sociais. Fenómenos como a desinformação, o compromisso de dados privados e a perversidade do modelo de negócio baseado em cliques são faces desta mudança. Também o papel do trabalho sofreu transformações severas.

Além da criação de empregos no sector tecnológico, a transição de uma economia baseada na transformação de matérias primas para uma baseada na atenção fez-se sentir em toda a cadeia de valor. A grande fonte de valor deixou de ser o processamento de matérias primas e passou a ser informação, num entendimento alargado que vai desde o conteúdo noticioso ao mais puro entretenimento. A atenção e o rasto online de milhões de pessoas, das suas relações e comportamentos, foi sucessivamente convertido em negócios das mais diversas formas, redefinindo direta e indiretamente o papel do trabalho.

O aparecimento de empregos bem pagos no sector tecnológico é contrabalançado pela delegação de funções que implicam um trabalho mais exaustivo e custoso para zonas do globo onde a mão de obra é mais barata, e desregulada. É-o também por uma exploração predatória dos dados gerados pelos utilizadores sem qualquer remuneração — a normalização de um trabalho invisível e predatório que dava tema para mais um ensaio.

Mas a transformação não se fica por aí. Se as empresas tecnológicas prometeram melhorar relações sociais com a mercantilização de soluções tecnológicas e acabaram por reforçar as desigualdades existentes e criar novas, à medida que se descobrem novas formas de gerar valor em relações com estes pressupostos repete-se a necessidade de fugir do determinismo tecnológico para indagar sobre o ambiente socio-político em que se inserem.

Este ciclo é notório no triunfo das redes sociais como promotoras de um tecido social global, das aplicações de TVDE e entregas globais. O surgimento da Inteligência Artificial é mais uma interação da mesma ideologia. Para anteciparmos os seus efeitos, e percebermos o seu potencial como ferramentas, e a relação com as profecias que têm alimentado, olhemos para a forma como perpetuam esta ideologia.

Afinal de contas, os grandes modelos de linguagem ou os modelos generativos de imagens alimentam-se dos dados gerados pelo complexo de vigilância do capitalismo tecnológico e resultam da concentração de poder computacional construída com os pressupostos desta digitocracia.

“On two occasions I have been asked [by members of Parliament], ‘Pray, Mr. Babbage, if you put into the machine wrong figures, will the right answers come out?’ I am not able rightly to apprehend the kind of confusion of ideas that could provoke such a question.”

— Charles Babbage

Falar sobre um tema tão complexo como a Inteligência Artificial implica começar por esta expressão. O conceito é usado para referir uma grande diversidade de tecnologias que incluem um número igualmente vasto de comportamentos considerados inteligentes. As aplicações da Inteligência Artificial variam desde a visão computacional, o reconhecimento de padrões, até aos modelos generativos de imagem ou texto, como os que se tornaram mais populares.

O GPT é aquilo a que se pode chamar um Grande Modelo de Linguagem, e é considerado um marco na área do Processamento de Linguagem Natural — o segmento da I.A. que procura equiparar-se à linguagem humana. Mas, se os resultados são surpreendentes, a história recomenda uma análise prudente. Tanto da perspetiva tecnológica como política.

Afirmar as capacidades da máquina em função do humano implica uma visão do que é humano, do que é uma máquina e de como fazer o segundo mais parecido com o primeiro. É na forma como se operacionaliza esta visão que a ideologia entra na equação. Numa publicação no site da OpenAI com o título “Planing to the AGI and Beyond”, o CEO Sam Altman revela os planos da empresa. Por um lado, reforça a crença de que estão no caminho de uma inteligência artificial geral e, por outro, elenca duas componentes estratégicas que ajudam a perceber as suas contingências: o secretismo e a escala (que se relaciona com a quantidade de dados).

“Por exemplo, quando começámos a OpenAI, não esperávamos que a escala fosse tão importante como acabou por ser. Quando nos apercebemos que seria fundamental, também percebemos que a nossa estrutura original não iria funcionar – simplesmente não conseguiríamos angariar dinheiro suficiente para cumprir a nossa missão como organização sem fins lucrativos – e por isso criámos uma nova estrutura.”

Se o secretismo se torna interessante por ser incomum na área da I.A. — na qual a partilha dos desenvolvimentos é uma tradição —, é fácil de compreender à luz das dinâmicas de mercado a que nos fomos habituando. A questão da escala tem outro significado.

Para se ter uma ideia da quantidade de dados por detrás destes modelos de Inteligência Artificial, uma estimativa sobre o GPT 3.5 calculava que se fossem traduzidos em texto, um humano demoraria cerca de cinco mil anos a lê-los, mesmo que se dedicasse 24 horas por dia. Para os computadores, o processamento desta informação não é menos intensivo. Segundo cálculos da Lambda Labs, para treinar um modelo como o GPT 3.5, recorrendo ao GPU mais barato do mercado, seriam precisos cerca de 4,2 milhões de euros e… 355 anos. E se isso explica porque apenas um conjunto muito restrito de empresas desenvolve os seus modelos, e deixa pistas para o custo energético destas operações, existem outras nuances igualmente importantes.se

Um dos melhores retratos surge no artigo publicado em 2020 por Emily Bender, Timnit Gebru, Angelina McMillan-Major e Margarett Mitchell: On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? ?. Nele, as autoras refletem sobre a tendência que se começava a generalizar de se associar a dimensão dos modelos às suas capacidades, e as suas implicações sistémicas adjacentes. Além de discutirem os custos sociais e ambientais do engrandecimento dos modelos, levantam outras questões importantes sobre estes modelos e as suas capacidades.

Sem entrar em detalhes sobre as tecnicalidades, é importante saber que dada a imensidão dos dados utilizados no desenvolvimento destes modelos, no método escolhido para os treinar, a intervenção humana é minimizada ao máximo. Assim, os dados com que o modelo é treinado não são selecionados, curados ou revistos. Neste domínio, as investigadoras, com diferentes especializações desde a filosofia à linguística, alertam para a iminente replicação e amplificação de vieses e de outros problemas contidos nos dados de treino. A sua crítica à inteligência destes modelos vai mais longe, e desafia diretamente as narrativas mais populares que se têm criado.

Para as investigadoras, estes modelos de linguagem não têm qualquer compreensão da linguagem, dominando apenas o lado formal e simbólico, mas emulam-na de forma a que possa induzir em perigosas efabulações até os mais treinados engenheiros. E se é esta ideia equivocada está na base dos maiores exageros que temos lidos sobre as capacidades de a I.A. e a possibilidade destes modelos terem uma inteligência geral, é importante analisá-la sob duas perspectivas.

É, por isso, necessário questionar-se simultaneamente quão inteligentes são estes modelos, em que definição de inteligência se inserem, se é que o são realmente, e para que servirão.

“A deus ex machina will never appear in real life so you best make other arrangements.”

– Marisha Pessl

No fundo, há uma divisão. Não há dúvida do potencial transformador — talvez até revolucionário — das tecnologias baseadas em I.A, nomeadamente os Grandes Modelos de Linguagem. Mas, por outro lado, como podemos contextualizar todas as afirmações ambiciosas feitas sobre a potencial substituição de empregos? Será a máquina assim tão inteligente? Será importa realmente? As pistas para a resposta estão na história da procura da medição da inteligência.

Francis Galton, estatístico e eugenista, primo de Charles Darwin, foi um dos primeiros a enveredar nesta missão. Em 1882, inaugurou o primeiro instituto para “testes mentais” procurando encontrar determinantes físicos associados à inteligência, o que acabou por falhar. Pouco mais de duas décadas depois, foi por comissão do governo francês que Alfred Binet, Victor Henri e Théodore Simon desenvolveram o teste de Binet-Simon, o precursor para os testes de inteligência modernos.

Interessados em perceber que crianças estavam a ter dificuldades em acompanhar os seus pares para as poder ajudar, o trio de investigadores desenvolveu um teste para medir a idade mental das crianças, notando sempre que se observava uma distribuição relativamente variada de inteligências para qualquer idade. Por outras palavras, queriam evitar deixar pessoas para trás, avisando que comparações quantitativas ou individuais entre os resultados dos testes não tinham fundamento científico. Apesar disso, o teste de Binet-Simon começou a ganhar tração pelo mundo ocidental e as comparações não só não pararam como subiram de tom, levando até ao surgimento de uma tradição eugenista de comparar nações e raças com base em medições de inteligência.

O culminar deste movimento surgiu com Richard Lynn e Charles Murray. Estes dois pseudocientistas, às costas de um historial eugenista, ajudaram a popularizar algo que, ingenuamente, não parece problemático: a ideia de que a inteligência, algo tão difícil de definir até hoje, pode ser medida objetivamente, em testes como o QI. Num dos trabalhos que viria a ficar mais famoso ao gerar controvérsia, “The Bell Curve”, Murray e o co-autor Herrnstein não só afirmaram a relação entre os resultados do QI e etnia, uma perspectiva considerada racista, como sobrevalorizaram o papel deste teste como indicador de uma habilidade tão geral como a inteligência.

Esta noção é questionada e refutada há décadas por cientistas como James Flynn, que apontam para o viés cultural dos próprios testes de QI; para o facto de se focarem em poucas habilidades e, por isso, refletirem uma visão pouco ampla de inteligência; e, ultimamente, para a perversa associação estabelecida entre inteligência e genética, refutada por investigações que comprovam consistentemente a importância de outros factores, como a socialização ou a nutrição. Contudo, uma certa teimosia epistemológica em certos círculos académicos permitiu a sobrevivência da inteligência enquanto métrica de comparação — e o campo dos modelos preditivos é terreno fértil para esta área de pesquisa.

Num “artigo” (sem revisão de pares) produzido por investigadores da Microsoft em 2023, os investigadores afirmam ter descoberto indícios de inteligência no modelo mais recente da OpenAI, o GPT4. Mas há um problema ético: a definição de inteligência proposta remete diretamente para um editorial escrito em defesa do livro “The Bell Curve” perante acusações de eugenia e racismo levantadas na altura da sua edição. Além disso, os problemas técnicos e científicos, desde suposições consideráveis e injustificadas até metodologias no mínimo questionáveis ou incompletas, também não ajudam — a leitura desta produção da Microsoft aproxima-se mais de publicidade do que de ciência.

É este ambiente epistemológico — em que o valor da ciência se restringe à sua performance — que faz com que a medição objetiva de conhecimento noutras áreas pareça plausível, e ajuda a explicar o surgimento dos cabeçalhos sobre como os que dizem que a I.A. se tornou perita em medicina e lei. Os métodos usados para avaliar os modelos são baseados na suposição do desempenho em todas as tarefas poder ser medido com recurso a testes escritos — que por sua vez significam alguma forma de inteligência — e que responder a uma bateria de diferentes testes em diferentes áreas se traduz num incremento das capacidades do modelo, o que não é necessariamente verdade.

Por um lado, como se verificou nos testes de código do GPT4, não sabendo os dados em que são treinados os modelos, é impossível aferir se certas respostas resultam de algum tipo de processo análogo ao raciocínio, ou se resultam simplesmente da memorização de determinadas informações. Por outro, como evidencia Timnit Gebru, os modelos generativos de texto são concebidos sem um objetivo concreto, tornando a sua avaliação geral numa tarefa abstrata e difícil de concretizar. Acresce ainda que a medição dos riscos associados a estes modelos parece impossível — sem conhecimento concreto sobre o que podem fazer, não podemos saber os riscos associados.

São uma ferramenta que — de acordo com os seus melhores publicistas — podem fazer qualquer coisa em qualquer circunstância. Uma narrativa que também se inspira nas concepções transhumanistas de inteligência: na ideia de que é possível replicar computacionalmente todas as habilidades cognitivas do humano e até melhorá-las, criando seres moral e intelectualmente superiores ao humano.

Este deus ex machina — a I.A. enquanto solução para todos os problemas e moralmente superior ao humano — não é mais do que uma máquina elevada a deus. E, por enquanto, só humanos podem ser responsabilizados por construir altares.

“The value of an idea lies in the using of it.“

– Thomas Edison

As empresas que agora se capitalizam com estes produtos têm um interesse ativo em exagerar e extrapolar as suas competências enquanto nos convencem de que estão a salvar a humanidade do cataclismo iminente. Comercializam cada vez mais soluções baseadas nestes modelos, implementam-nos em todas as instâncias das suas plataformas ao mesmo tempo que condenam o risco existencial para a espécie humana.

Sam Altman disse recentemente ser mais fácil fazer as pessoas agir se as confrontarmos com uma ameaça existencial. Se este paradoxo recorda as palavras de Mark Fisher/Frederic Jameson — “É mais fácil imaginar o fim do mundo do que o fim do capitalismo” —, a apropriação mais adequada seria qualquer coisa como: é mais fácil imaginar o fim do mundo do que admitir as falhas da I.A. corporativa. As mesmas pessoas que anunciam o apocalipse descrevem os modelos como ferramentas de propósito geral, capazes de desempenhar qualquer tarefa, e selam contratos para o uso desta tecnologia (por exemplo com o Estado português1,2) num ambiente ainda vazio de regulação. E de compreensão.

Como vimos, a combinação entre a capacidade de gerar texto fluente com algumas informações aparentemente corretas faz com que a capacidade dos modelos seja altamente sobrestimada. Também o seu risco de destruir a humanidade parece um tanto ou quanto desligado da realidade. E, no meio disto, as verdadeiras questões que devíamos estar a fazer sobre estes grandes modelos de Inteligência Artificial, as suas capacidades e as suas contingências ficam à margem.

Assumir que os modelos não processam a informação e não compreendem a linguagem natural como os humanos não significa que a forma como o fazem seja inútil. Significa que a forma como extrapolamos o que é possível fazer a partir desse processo não deve ser feito em reflexo do humano, e em constante antropomorfização. Este modo de pensar sobre os modelos de Inteligência Artificial induz facilmente em erro e cria cenários em que o potencial uso incorrecto dos modelos pode chegar mesmo a ser perigoso.

Por de trás da percepção gerada de que profissões podem ser inteiramente substituídas por modelos generativos estão especulações puramente tecnocráticas, sem qualquer validação prática, que remetem para um processo puramente matemático questões que num ambiente real poderiam implicar outro tipo de valências — como alertava Weizenbaum. Ignoram-se questões gerais, como o facto dos modelos de I.A. não saberem o que sabem, o que faz com que possam gerar respostas completamente falsas da mesma forma que geram respostas verdadeiras, sem demonstrar qualquer incerteza. Ou ignoram-se outras questões particularmente interessantes para sociedades tendencialmente excluídas de diálogos globais, como a sub-representação das línguas e culturas nos dados usados para treinar estes modelos1.

A provar este desfasamento entre as expectativas das capacidades das máquinas e a sua utilização em ambientes reais estão casos recentes em que a automação quase completa das tarefas fez cair abruptamente o valor real do seu desempenho. Exemplo disso são os relatórios feitos pelo portal de informação tecnológica CNET com recurso ao ChatGPT — apesar da confiança dos diretores e editores da publicação, foram encontrados erros graves em mais de 50% dos artigos produzidos. Ou o caso da linha de auxílio para distúrbios alimentares que, depois de despedir as trabalhadoras que se sindicalizavam à procura de melhores condições de emprego e de as ter substituido por um ‘bot’, teve de recuar na solução tecnológica ao receber relatórios de que este bot estaria a dar conselhos perigosos.

Ambos os casos revelam como mais do que oferecer soluções concretas para problemas existentes, estas tecnologias surgem muitas vezes enquadradas como forma de reduzir o custo do trabalho. São escolhidas não pela sua adequação à função mas por a desempenharem de uma forma suficientemente convincente, mesmo que esse convencimento parta de um entendimento puramente mercantil de relações sociais.

“When the spiders unite they can tie down a lion.”

Provérbio etíope

Se depois de analisados os LLM não se revelam propriamente uma panaceia, continuam a constituir algo que, dentro do padrão neoliberal, inspirado pela cultura da Califórnia, é aliciante. É a possibilidade de substituir pela via tecnológica uma relação, alterando a organização social, desvalorizando o papel dos trabalhadores, conseguindo assim maior lucro através da mesma matéria prima – os dados.

Na ausência de regulação ou taxação da automação, torna-se muito mais lucrativo para uma empresa ter uma subscrição para um modelo generativo razoável do que uma trabalhadora competente. As preocupações com condições laborais sumem-se quando o motivo predominante do negócio é o lucro – o importante não é que os modelos sejam bons, mas que permitam cortar custos. Mas estará este cenário iminente?

A União Europeia planeia desenhar um pacote de regulação que impeça a utilização dos sistemas de Inteligência Artificial em ambientes críticos em que o seu uso possa gerar consequências graves, mas a verdadeira batalha pode ser cultural. É importante promover entendimentos corretos dos modelos, e evitar caminhos simplistas e conclusões óbvias. Se há coisa a que os últimos anos de explosão tecnológica nos habituaram foi a promessas catastroficamente falhadas, como a bolha dotcom, a primeira geração de redes sociais, ou o recente entusiasmo em torno das criptomoedas e do metaverso — onde, por exemplo, a Meta, detentora do Facebook, investiu e perdeu milhares de milhões.

É certo que os modelos de Inteligência Artificial deram um salto considerável nos últimos tempos, e a sua arquitectura evoluiu. E não há, por enquanto, razões plausíveis para assumir o seu potencial de automação massiva de todas as tarefas desempenhadas pelo ser humano. Ainda assim, é importante que se veja este cenário como ameaça às condições laborais.

Se a substituição completa é improvável, mais provável é a relocalização do trabalho para uma função de supervisão das máquinas com condições contratuais degradadas — imaginemos o caso do jornalista que se torna revisor de textos gerados por I.A. Isso não só acontecerá cada vez mais num futuro como já hoje acontece, com efeitos à vista. Mas será resultado da evolução tecnológica ou do retrocesso político e social em torno da profissão? Olhar para mercados como o português, onde a crise do jornalismo tem carácter sistémico, mostra como é complexa a resposta a esta pergunta.

Os modelos de linguagem poderiam contribuir para um aumento do valor intrínseco do trabalho do jornalista ao permitir-lhe, por exemplo, a coligação de mais fontes de informação, a transcrição de horas de áudios de forma mais célere, ou até contribuir para uma maior acessibilidade ao trabalho jornalístico com tecnologias automáticas de legendagem e leitura. Mas aquilo que temos visto ( e que tem sido notícia) não segue essa direção: vimos a criação de um jornal com ChatGPT em Portugal e os anúncios do CEO de um dos principais grupos de media europeus de que a força de trabalho humana poderia ser substituída, sem que a resistência social tenha sido especialmente audível.

A implementação tecnológica depende de uma complexa teia de relações e da maneira como vemos diferentes profissões. A automação não tem de ser uma ameaça ao bem estar das sociedades: uma implementação democrática da automação pode até ser libertadora, criando novas oportunidades de redução laboral e convivialidade. Contudo, uma democracia que represente todos não é algo que nos possa ser atribuído — é algo que se pratica.

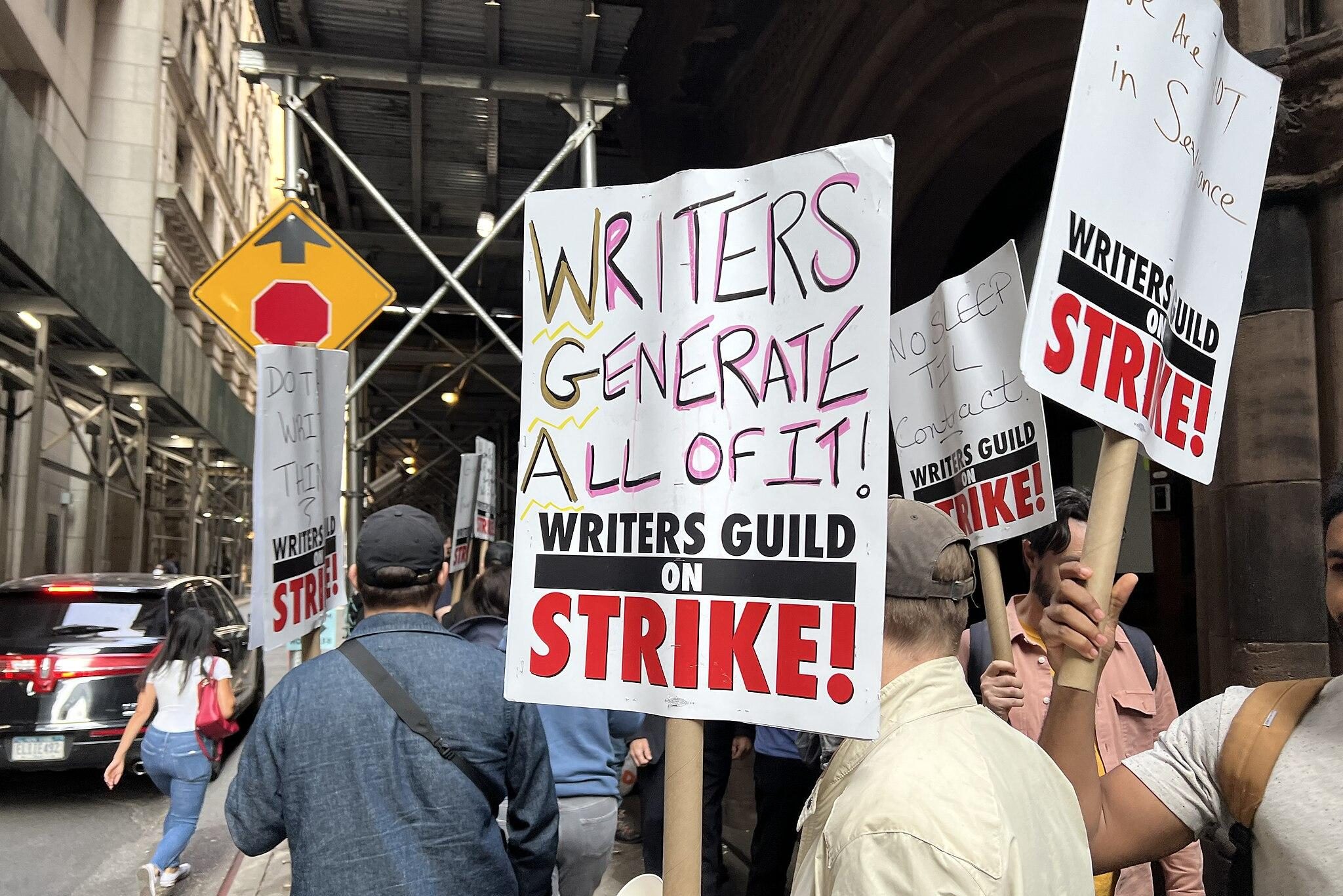

Nos Estados Unidos da América, a greve dos guionistas — ameaçados pelos seus estúdios com o fantasma da automação — serve como breve caso de estudo. Se o capital triunfar sobre os esforços dos guionistas, é esperado que abra precedentes perigosos em outros campos também ameaçados pelos modelos preditivos. Em Nairobi, na Nigéria, o primeiro sindicato no continente africano de moderadores de conteúdo (pessoas mal pagas para filtrar e anotar conteúdo para plataformas sociais ou de IA) começa a nascer, reivindicando proteção essencial à progressão inconsequente da supremacia dos dados e do seu impacto nos trabalhadores — muitos moderadores de conteúdo sofrem de stress pós-traumático.

O determinismo tecnocrático convence-nos do progresso implacável destas tecnologias, mas elas não são nada sem as pessoas que as criam e usam. O mundo vai ser diferente, mas não podemos pensar no rumo da mudança como uma rota pré-estabelecida.

1- O português, falado nativamente por 3.3% da população mundial, representa apenas 1.1% da maior base de dados de texto disponível; no caso de línguas excluídas do ocidente a diferença é ainda mais gritante — o Hindi, língua nativa de 7.4% da população mundial, corresponde a 0.15% dos dados de treino. O inglês, por outro lado, falado nativamente por 5.7% da população mundial, corresponde a mais de 40% dos dados de treino.

Uma parceria

José é uma pessoa que faz investigação em deep learning e imagem clínica. Vive com uma interesse mais ou menos flutuante em compreender o mundo - como ele é e como pode vir a ser. Faz produção nas horas vagas como Z G A.

Ver todos os artigos Ver todos os artigosApoia a partir de 2€/mês, recebe uma newsletter exclusiva, acesso a descontos e passatempos, e contribui para mais textos como este.

Outros artigos de que podes gostar: