A inteligência artificial tem avançado a olhos vistos, com máquinas mais capazes de produzir um discurso coerente ou, por outro lado, criar imagens verossímeis de situações que nunca aconteceram – especialmente, de simular discursos na voz e na face de quem nunca os proferiu. Se toda esta evolução pode ser assustadora e levar Estados e Governos a criar nova legislação, a verdade é que surge muito por incentivo comercial – fruto de avanços tecnológicos com procura e intuito comercial. Veja-se o exemplo da app que na China democratizou os deepfakes e dominou durante semanas o top de aplicações mais descarregadas.

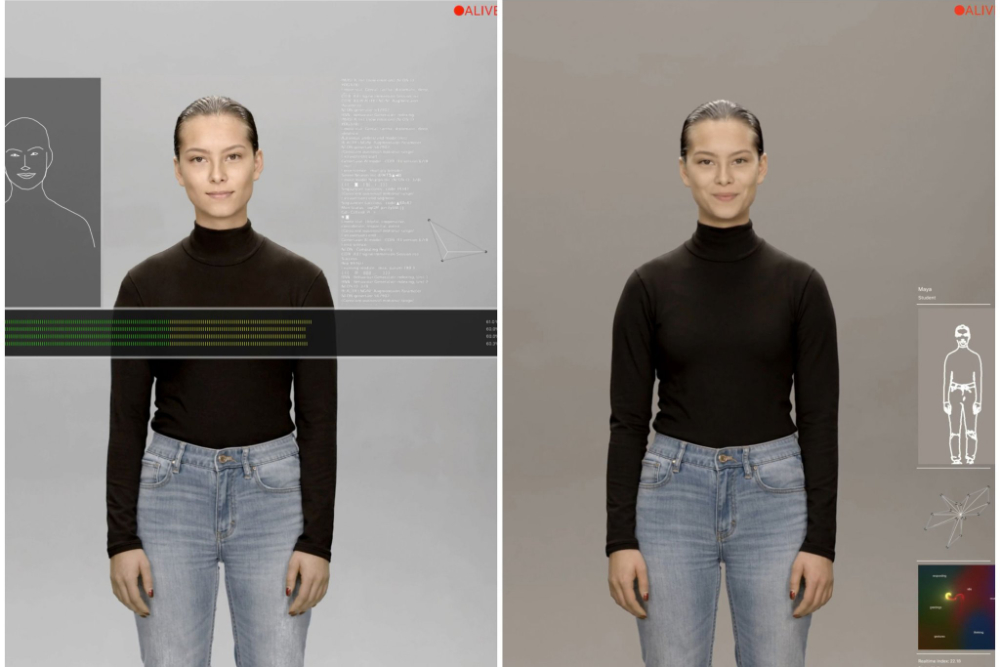

Outros exemplos vêem-se não a jusante, junto do público, mas a montante, nos seus lançamentos – como é o caso do projecto NEON da Samsung. Com o intuito de criar personagens fidedignas que possam servir por exemplo como pivôs de notícias ou assistentes pessoais em sites com figuras humanas, a Samsung está a desenvolver tecnologia para a partir de dados capturados criar avatares em três dimensões capazes de desenvolver os seus próprios gestos, expressões faciais e maneirismos. O resultado é uma espécie de personagem de Sims ultra-realista, sobre o qual ainda pouco se sabe.

As mais recentes imagens a virem a público foram reveladas no Reddit e compiladas pelo canal de tecnologia Good Content; são as primeiras pistas a dar corpo a uma das ideias que Pranav Mistry, CEO da Samsung STAR Labs, havia antecipado numa entrevista no final do ano – que em breve viveríamos num mundo povoado por máquinas com aspecto humano que poderiam desempenhar diversas funções. Na mesma entrevista, é o próprio a chamar a atenção para o facto de tanto empresas tecnológicas como governos terem de criar novas políticas para lidar.

A caminho da CES – grande feira tecnológica que acontece habitualmente no início do ano em Las Vegas – foi o próprio Pranav a dar mais novidades sobre o desenvolvimento do que chamou CORE R3, anunciando que os avatares já conseguem gerar expressões autonomamente e falar em línguas diferentes das que tinham sido originalmente programadas.

Flying to CES tomorrow, and the code is finally working 🙂 Ready to demo CORE R3. It can now autonomously create new expressions, new movements, new dialog (even in Hindi), completely different from the original captured data. pic.twitter.com/EPAJJrLyjd

— Mistry (@pranavmistry) January 5, 2020