Videovigilância equipada com inteligência artificial (IA) para reconhecimento de indivíduos começa a ser comum em lojas, escritórios ou espaços públicos, constituindo uma nova e poderosa forma de segurança mas também de surveillance. Pode parecer impossível escapar a tal escrutínio; todavia, investigadores de uma universidade belga dizem ter encontrado uma forma de o fazer.

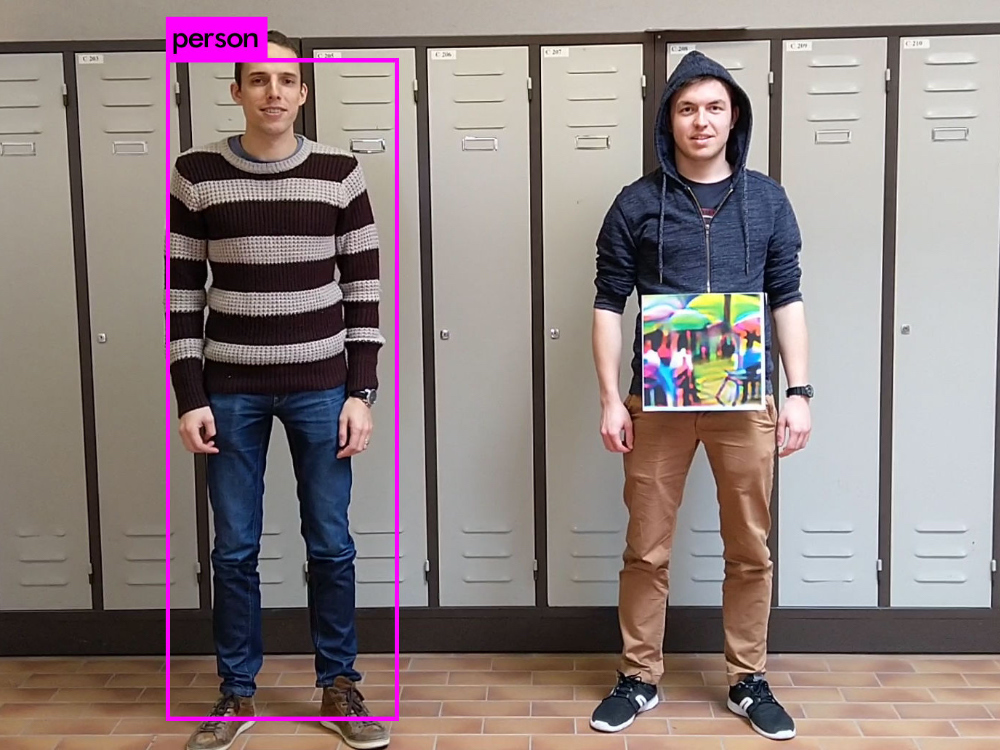

Os autores da investigação agora publicada, e que pertencem à KU Leuven, mostram ser possível escondermo-nos de um sistema de videovigilância com IA através da impressão de um desenho colorido específico, que eles próprios criaram. Com essa imagem pendurada ao pescoço, por exemplo, o sistema não detecta a pessoa. Os investigadores recorreram a um mecanismo de reconhecimento disponibilizado em código aberto e chamado YoLo(v2).

Como escreve o MIT Technology Review, o truque tanto pode permitir que criminosos se escondam de câmaras de segurança como oferecer a dissidentes uma forma de evitar escrutínio governamental. “O que o nosso trabalho prova é que é possível contornar sistemas de videovigilância usando patches adversários”, comenta à mesma publicação um dos autores da investigação, Wiebe Van Ranst. O cientista diz que cada sistema é um sistema, mas que não deve difícil adaptar o desenho a cada caso. “O que gostaríamos de fazer no futuro é gerar um patch que funcione em múltiplos detectores ao mesmo tempo.”

Para criarem o desenho, a equipa belga recorreu a uma técnica conhecida como ‘aprendizagem automática adversa’, que consiste em alimentar uma rede neural com imagens que possam confundir ou enganar o sistema de IA. Este trabalho belga surge num contexto em que algumas lojas experimentais da Amazon e de outras empresas recorrem a sistemas de videovigilância inteligentes para evitar filas em caixas, ou que na China essa tecnologia é usada para apanhar criminosos ou perseguir determinados grupos étnicos.