Por coincidência (vamos fingir que acreditamos), estas últimas semanas ficaram marcadas por uma torrente de anúncios de tecnológicas. Como é habitual, Google e Microsoft apresentaram as novidades em semanas dedicadas à demonstração dos seus produtos e, este ano, um novo elemento juntou-se a esta festa. Falamos obviamente da OpenAI, que fez a sua primeira apresentação em directo. Começando pelo I/O da Google, passando pela OpenAI e terminando na Microsoft, todas as apresentações tiveram as suas diferenças – desde logo na estética do palco, como notou Sam Altman enquanto jurava não pensar assim tanto na concorrência –, mas tiveram um denominador comum. Escusado será dizer que esse denominador comum se chama Inteligência Artificial.

Sobre as novidades mais sonantes, é provável que já tenhas ouvido falar. Muito resumidamente: o GPT agora fala, a Google quer pôr IA em tudo, e a Microsoft vai lançar o primeiro portátil totalmente assistido com IA. Substancialmente, pouco mudou nos modelos de Inteligência Artificial por detrás destas novas aplicações. À parte de algumas afinações, do treino em mais dados que aumentará a capacidade em alguns domínios específicos e da concatenação de tecnologias e arquitecturas que permite processar informação de diferentes tipos (texto, áudio, imagem, vídeo), os fundamentos do que foi apresentado mantêm-se os mesmos dos últimos anos. E as profecias de que este é o caminho para a grande revolução da humanidade também.

A fé na escala dos modelos, que se traduz na ideia de que quanto maiores — e com mais dados — forem, melhor serão, continua bastante presente no que vai sendo anunciado; ao ponto de já não representar grande novidade. Pelo que, o mais interessante neste momento é perceber como tecnológicas consolidadas estão desesperadamente a tentar criar qualquer-coisa-com-AI para o seu leque de serviços digitais; no caso da OpenAI, qual a nova funcionalidade com que nos tentarão impressionar. E quais os custos deste modelo de inovação.

GPT4 fala, mas os empregados da OpenAI não

2024 marca o ano em que a OpenAI se junta à tradição das keynotes. Num ambiente bastante diferente do que é habitual nas outras tecnológicas, foi num palco com aspecto de sala de estar, e projetando slides minimalistas num ecrã muito mais pequeno do que é habitual, que a OpenAI apresentou o GPT-4o. Esta aplicação distingue-se das anteriores por ser capaz de processar com uma velocidade superior dados em áudio e em vídeo, mas segue em toda a linha a tendência da empresa de exagerar nas palavras que usa para descrever os fenómenos.

Na habitual página de apresentação que reúne as informações do que é apresentado ao vivo, o GPT-4o é apresentado como tendo a capacidade de raciocinar em texto, vídeo e áudio, dando respostas com uma velocidade próxima da velocidade média das interações entre humanos. E se o termo raciocínio é claramente um exagero – como abordámos numa entrevista com Emily Bender – a questão da velocidade é fundamental. Até porque, anteriormente, já era possível usar a voz para interagir com o GPT, utilizando o Voice Models. Aqui a novidade está no facto do GPT-4o ser uma combinação de tecnologias que torna todo esse processo computacionalmente mais directo (e não dependente da interação entre diferentes modelos), o que faz com que haja uma menor perda de informação, que se pode traduzir em maior validade das respostas e numa maior velocidade, elemento fundamental para atribuir a verosimilhança. E para desbloquear funcionalidades que até agora eram difíceis de concretizar, como a tradução automática.

Por outro lado, e apesar do reconhecimento de que novos modelos, com novas capacidades, acarretam novos riscos, os métodos de segurança e de prevenção que foram postos em prática no desenvolvimento deste modelo mantiveram-se mais ou menos os mesmos. Bem como as questões de fundo, nomeadamente sobre o licenciamento dos dados de treino – tema que foi mencionado para anunciar um acordo milionário com o Reddit que permite o acesso aos dados e levará em breve funcionalidades de IA para a plataforma. De resto, foi um fenómeno colateral relacionado com o material de treino a catapultar esta apresentação para a habitual controvérsia.

Uma das vozes apresentadas como interface do GPT-4o era, como escreveu Brian Merchant neste artigo que publicámos no Shifter, “suspeitosamente parecida com a de Scarlett Johansson no filme Her”. O caso fez correr muita tinta, levando a actriz a fazer um comunicado afirmando que não tinha autorizado a utilização da sua voz neste assistente, apesar dos pedidos da OpenAI; mas não só. Na mesma nota, Johansson convida a uma reflexão profunda (e acrescentamos nós, urgente) sobre o desenvolvimento destes sistemas com capacidade de emular o trabalho e a identidade das pessoas, num mundo em que a desinformação e os deepfakes são uma realidade cada vez mais preocupante.

“Numa altura em que todos nos debatemos com deepfakes e com a proteção da nossa própria imagem, do nosso próprio trabalho, da nossa própria identidade, creio que estas são questões que merecem uma clareza absoluta”, afirmou Johansson. E não foi a única por estes dias a criticar a estratégia da OpenAI.

Mais ou menos ao mesmo tempo em que decorria a polémica com ScarJo, uma série de demissões reminiscentes do que aconteceu há uns meses mostraram como, mesmo dentro da OpenAI, não há um consenso em torno de quais devem ser as prioridades, nem um acordo sobre o que deve ser feito. Ilya Sustskever e Jan Leike, dois elementos proeminentes da equipa de desenvolvimento e segurança, respectivamente, demitiram-se. E se o primeiro não adiantou muito, mas já tinha expressado este tipo de preocupação antes, o segundo deu como justificação o facto de a empresa se dedicar mais a criar produtos brilhantes do que a investigar sobre segurança e mitigação dos riscos dos seus produtos. O caso não seria especialmente surpreendente se o historial da OpenAI não fosse tão marcado pela tentativa retórica de se assumirem como os grandes criadores de IA em benefício da humanidade.

Como escreve numa longa peça em que ecoa as queixas feitas por antigos empregados da OpenAI, a publicação Vox (da qual apropriámos o título deste capítulo), o desígnio de beneficiar a humanidade implica um grande nível de confiança que não se coaduna com as práticas que têm sido tornadas públicas. Mais recentemente e na sequência das demissões, documentos citados nessa peça da Vox dão conta de um ambiente dentro da empresa de alta pressão, onde as preocupações dos seus empregados não são tidas em conta; e de acordos feitos com quem abandonou a empresa que os deixou perante o dilema de abdicar de acções que tinham da empresa ou criticá-la livremente ou falar do que se passa internamente.

Na mesma toada, o jornalista Gary Marcus lembra que em Novembro de 2023 a empresa pediu um regime fiscal diferenciado alegando o seu compromisso com a humanidade; mas, na prática, pouco se tem visto em termos práticos neste sentido. Com a equipa de segurança e alinhamento a abandonar o barco, expressando preocupações sobre a falta de atenção dada a este capítulo, e todas as inovações apresentadas pela OpenAI a seguirem a mesma lógica – de um chat com novas capacidades e ignorando todos os problemas detectados – é cada vez menos claro o que quer a OpenAI dizer com “benefício” ou “humanidade”, e se isso vai para além da valorização da sua empresa.

ScarJo is just the tip of the iceberg.

— Gary Marcus (@GaryMarcus) May 23, 2024

As recently as November 2023, OpenAI promised in their filing as a nonprofit exempt from income tax to make AI that that “benefits humanity … unconstrained by a need to generate financial return”.

The first step towards that should be a… pic.twitter.com/cm8Xd8BsVJ

&udm=14

Se a OpenAI é a grande protagonista deste capítulo da IA, e a Microsoft a personagem secundária que serve como coadjuvante na jornada do herói, a Google é a competidora mais bem posicionada para ir dando respostas de algo impacto. A empresa tem vários departamentos dedicados à pesquisa e desenvolvimento no campo da inteligência artificial, alguns deles com ótimos resultados que nem sequer chegam ao conhecimento público – veja-se como o Alphafold é praticamente desconhecido da maioria – mas nem por isso escapa à tendência de pôr IA em tudo quanto é serviço. E o mais recente Google I/O foi prova disso.

Se a OpenAI apresentou o seu GPT-4o, com novas capacidades, a Google respondeu na mesma moeda, reforçando o Gemini e dando-lhe algumas capacidades de processamentos de dados que não tinha antes. Contudo, e porque este artigo não é sobre o que foi dito, mas sobre o que ficou por dizer, as mudanças apresentadas pela Google no seu produto-estrela, a pesquisa, são um exemplo paradigmático da diferença de ritmo entre as intenções de mercado e a maturação das tecnologias. E de uma inovação que começou a falhar espetacularmente.

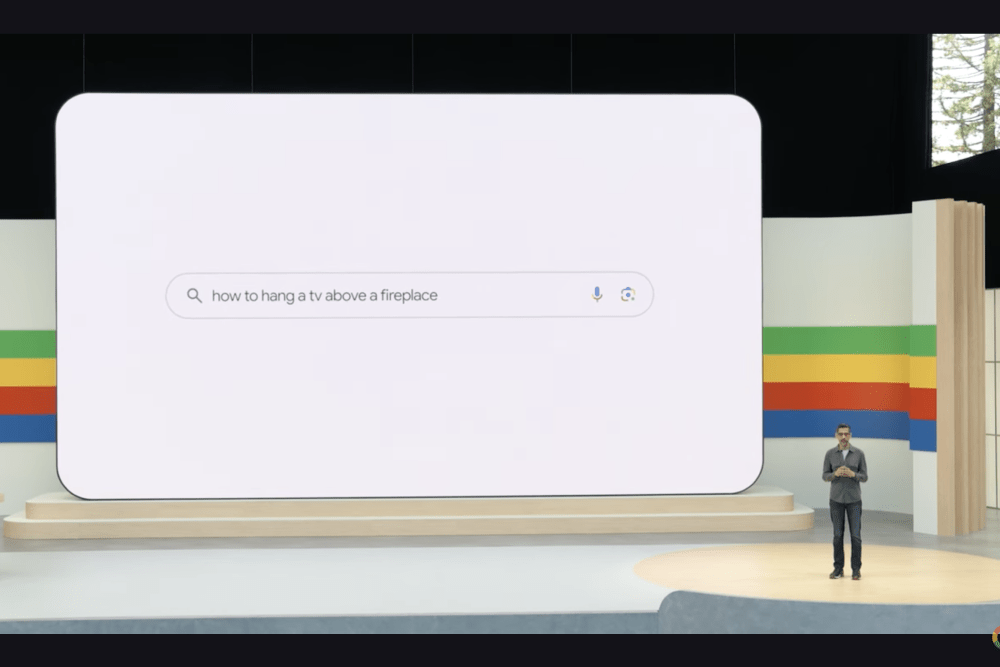

A Google apresentou o AI Overview, que consiste, basicamente, numa evolução da funcionalidade já existente, que pretende substituir os links que surgem em resultado de pesquisa por uma só frase ou resumo do assunto pesquisado, mas neste caso utilizando o grande modelo de linguagem para gerar as respostas. Se a funcionalidade foi apresentada pela Google numa demonstração com uma resposta duvidosa, e as respostas da IA são acompanhadas da etiqueta ‘experimental’, isso não demoveu a empresa de lançar a funcionalidade para um grupo muito alargado de utilizadores, o que tem dado azo a respostas absolutamente surreais e a uma degradação generalizada da qualidade daquele que é – sem grande risco de o dizer – um dos produtos tecnológicos mais utilizados da humanidade.

Google, FFS. pic.twitter.com/UHtLQ5SdpG

— Melanie Mitchell (@MelMitchell1) May 23, 2024

Google AI Overviews under fire for dangerous and wrong answers via @MrDannyGoodwin https://t.co/pEnQJqmhTz pic.twitter.com/KINpr9M6ok

— Search Engine Land (@sengineland) May 24, 2024

Pregnant ladies, don't forget your daily cigarettes! pic.twitter.com/7jKEp50S1k

— Xavier Larrea (@jxlarrea) May 24, 2024

Praise the Google AI Overlord (err, Overview) that will provide us salvation in the form of glue in our pizza, a small rock to eat every day, and our other pathetic biological needs. pic.twitter.com/yRJgv0eAsK

— Wayne Hsiung (@waynehhsiung) May 24, 2024

Se teoricamente a promessa parece interessante, na prática os resultados têm sofrido do mesmo mal que outras utilizações de IA do mesmo género. E a forma de mitigar estes erros não é tão clara como se possa pensar. Notícias recentes mostram que, tal como aconteceu por exemplo com o ChatGPT, a maioria dos erros graves que têm sido denunciados online estão a ser corrigidos manualmente. O que significa que muitas outras incidências passarão incólumes e atingirão, potencialmente, milhares de pessoas com recomendações como as que citámos.

Desde responder a utilizador que matar é bom, ou que juntar cola a queijo ajuda a derretê-lo, vários são os exemplos caricatos que mostram como esta funcionalidade não está, de todo, apta para um lançamento público. E os movimentos de resposta são de tal ordem que, na última semana, se popularizou o sufixo “&udm=14”, um pequeno código que se pode adicionar na pesquisa da Google de modo a fintar o assistente IA e aceder aos resultados como antigamente. De resto, este não é o primeiro sinal de que a IA está a tornar a pesquisa na Google… pior. A produção de conteúdos em massa com recurso a IA está também a inundar os resultados de pesquisa da Google, baixando a qualidade média dos resultados, algo para que os utilizadores também já foram desenvolvendo estratégias, como filtrar temporariamente a pesquisa para retribuir apenas resultados antes de 2022, e do lançamento do ChatGPT.

Se a consolidação da Alphabet (empresa-mãe da Google) torna surpreendente um falhanço tão espectacular da Google – alguns exemplos são verdadeiramente dramáticos –, um ex-funcionário da empresa que recentemente se despediu tem uma opinião forte sobre o caminho tomado. Na sua opinião, a Google está a repetir os erros que cometeu quando tentou correr atrás do hype das redes sociais, e a agir por puro pânico. Na altura, a equipa deste ex-colaborador fora responsável pela criação do Google+, a rede social da Google que ficaria conhecida por… nunca se tornar realmente conhecida. E o engenheiro teme que neste caso todos os erros estejam a ser repetidos.

Quanto aos temas centrais no universo da IA, como vimos anteriormente no caso da OpenAI, a conferência da Google também não trouxe grandes respostas. Tal como no caso da OpenAI, a Google anunciou um acordo com o Reddit para a utilização dos dados da plataforma nos seus modelos de IA. Algo que culminou na tal receita de queijo com cola; como mostra a investigação do site 404media, essa sugestão era proveniente de um comentário satírico num post de Reddit.

“We used to call it spyware”

A última apresentação da série coube à Microsoft. Neste caso, a empresa apresentou não só uma aplicação, mas todo um computador criado em torno da ideia da IA e equipado com o seu assistente – o CoPilot. A aposta é claramente uma tentativa de surfar a onda da IA para reposicionar a Microsoft no universo dos portáteis, mas, claro está, as inovações propostas levantam dúvidas que continuam por esclarecer.

A utilização do CoPilot em ambientes restritos por pessoas com conhecimento daquilo que estão a fazer tem-se revelado com uma ferramenta capaz de aumentar a produtividade dos trabalhadores. Seja auxiliando a gerar linhas de código, escrever e-mails ou textos para apresentações, a ferramenta — com capacidades semelhantes ao ChatGPT ou ao próprio Gemini — tem a sua utilidade, mas, mais uma vez, é tudo o que vai para além desse uso restrito que nos deve fazer pensar.

A par do lançamento da IA em-todos-os-processos-do-computador, a Microsoft anunciou uma nova função chamada Recall. No fundo, esta funcionalidade faz com que o computador vá fazendo várias capturas de ecrã durante a sua utilização, e torna-os pesquisáveis. Assim, um utilizador pode, por exemplo, pesquisar por um elemento que viu numa determinada fotografia, utilizando linguagem natural, e obter como resultado o preciso momento em que essa imagem lhe cruzou o ecrã. Se essa funcionalidade tem vantagens, mais uma vez, do ponto de vista teórico, na prática, especialistas em privacidade têm alertado para as potenciais consequências – e o regulador britânico avançou mesmo com uma investigação. A Microsoft afirma que a funcionalidade Recall foi feita tendo em mente a segurança e privacidade, que os screenshots são guardados no computador do utilizador e que só acedendo ao computador é possível utilizá-la, mas isso não exclui importantes preocupações.

Armazenar informações com potencial sensível, mesmo que seja apenas num equipamento, deve levantar sempre alguma preocupação, desde logo porque torna esse equipamento um alvo mais apetecível e susceptível a ataques. E se as utilizações correntes podem parecer triviais, é preciso pensar em casos extremos e ambientes sensíveis, como por exemplo o trabalho jornalístico em países hostis, a partilha de computadores por vítimas de violência doméstica e os seus agressores, ou os limites cada vez mais ténues entre a utilização pessoal e profissional dos computadores. Na generalidade, defensores da privacidade online apontam para o facto de funcionalidades como estas tornarem os computadores pessoais massivos agregadores de dados, mesmo do que é feito offline, tal como faria um programa de spyware.

O editor da Malware Bytes, uma página associada a um serviço anti-malware, descreve este momento da IA como um potencial momento social media 2.0, recordando que de um momento para o outro, há mais de 10 anos, as pessoas também começaram a partilhar os seus dados pessoais através de novas tecnologias sem medir o seu impacto.

Qual o custo de tanto benefício?

Apesar de os grandes anúncios em torno da IA terem muitos pontos assinaláveis, é importante não tomarmos o todo pelas partes. Enquanto estes lançamentos públicos trazem questões urgentes e que não vão sendo respondidas – como é apanágio do modelo de desenvolvimento de Sillicon Valley que nos trouxe, por exemplo, o caso Cambridge Analytica ou, até, a desregulação laboral implementada pela economia das plataformas — a verdade é que discretamente a IA evolui de uma forma que pode mesmo ser benéfica para a humanidade. E a verdadeira questão agora prende-se com o preço a pagar por essa inovação.

Enquanto dezenas de milhares de empresas tentam aproveitar as novas tecnologias de IA generativa para criar aplicações que sejam realmente úteis — não simples geradores de textos a metro ou de quadros decorativos — a narrativa mediática em torno da IA é completamente dominada pelo que vai sendo lançado em Silicon Valley. Sem uma reflexão crítica nem qualquer tipo de ponderação política, estas inovações são-nos vendidas apenas pela sua conveniência e espetacularidade no curto-prazo e como soluções para problemas definidos pelos departamentos de marketing.

Como disse Meredith Whittaker em entrevista ao Shifter, o modelo de desenvolvimento da IA corporativa parece não se focar em resolver problemas, ou em aumentar os direitos dos utilizadores, mas sim em aumentar as possibilidades do que se faz com os dados, mesmo que essas possibilidades não sejam propriamente benéficas ou que a relação custo-benefício seja difícil de calcular.

Se a digitalização da sociedade trouxe consigo grandes questões sobre os ecossistemas de informação, sobre privacidade, sobre custo energético, e essas questões se tornaram ainda mais prementes com a IA, é cada vez mais claro que não podemos esperar que sejam as grandes empresas e com milhares de milhões investidos a dar as respostas que queremos ouvir. Nem a ponderar sozinhas a relação custo-benefício. Hoje é inegável o papel que a IA pode ter enquanto ferramenta, como poder automatizar tarefas repetitivas ou até alargar os horizontes do conhecimento, dando respostas que outrora pareciam impossíveis. Mas é cada vez mais importante perceber que outros valores vão sendo destruídos. E arranjar formas de o fazermos democraticamente, porque nem tudo será protegido pela regulação por mais que esta se revista de boas intenções.