Numa entrevista recente ao jornalista Dwarkesh Patel, Mark Zuckerberg – já com o seu novo look, com óculos de massa e t-shirt larga – partilhou a sua visão para o futuro da Inteligência Artificial. Numa conversa que foi desde os últimos avanços do Llama à competição da chinesa Deepseek, Zuckerberg teve oportunidade de partilhar os seus planos para o futuro. Mas foi a sua reflexão sobre conexões humanas que me ficou na memória.

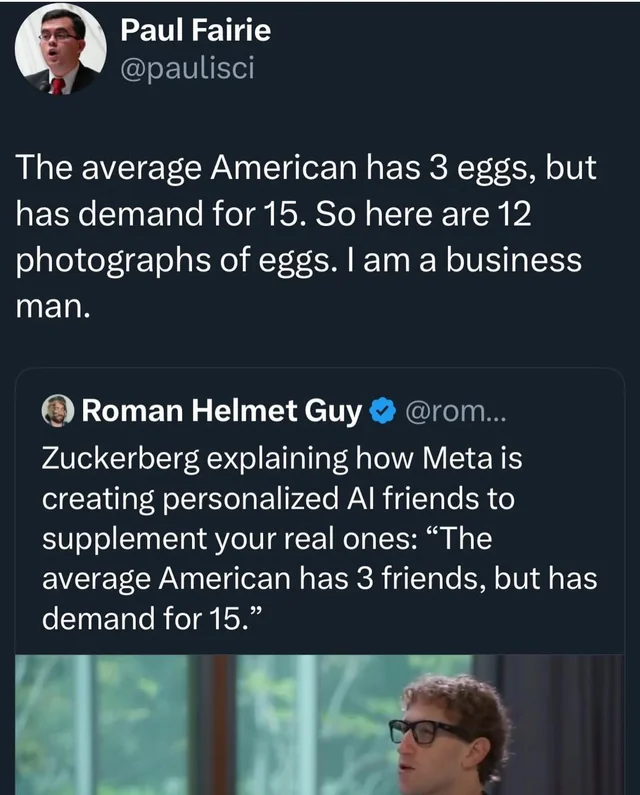

Numa tirada que entretanto se tornou viral, e alvo de muitos memes, Zuckerberg evocou um dado estatístico que diz que os americanos têm em média apenas 3 amigos, quando deviam ter 15, e deixou no ar a ideia de que a Inteligência Artificial pode servir para suprir a falta das restantes conexões. Como com quase tudo o que os CEOs de empresas deste género dizem, é preciso olhar para estas afirmações com ponderação, mas é certo que de alguma forma esta reflecte o imaginário em que a IA está a ser concebida.

Depois dos falhanços épicos no Metaverso, onde a Meta prometia juntar-nos a todos — mas acabou por nos tentar enfiar em salas virtuais vazias com avatares sem pernas, e sem qualquer interesse—, a nova proposta de Zuckerberg parece ir ainda mais longe. Para além dos avatares digitais que nos permitiriam contornar a distância física, Zuckerberg acredita que a Inteligência Artificial pode ser o antídoto para a distância emocional e a epidemia de solidão.

O CEO da Meta imagina que no futuro das redes sociais boa parte dos conteúdos serão avatares de inteligência artificial com quem podemos interagir sobre os mais variados temas e pretextos. E que os avatares podem servir múltiplos papéis nas nossas vidas. A forma como a sua empresa já vai procurando concretizar esse imaginário, e as dezenas de exemplos que existem de outras interações problemáticas, já nos permitem antecipar algumas questões do futuro.

O problema não está na Inteligência Artificial. O seu potencial transformador em domínios específicos tão díspares como a medicina, a física, a cibersegurança ou a gestão, é real. O verdadeiro problema é a forma como esse potencial é instrumentalizado para projetar na IA capacidades que reconhecemos e valorizamos noutros humanos — como a empatia, a criatividade ou a intuição — que pura e simplesmente esta tecnologia não possui. E como, consequentemente, os modelos de Inteligência Artificial são vendidos como solução para todos os nossos problemas: desde a falta de produtividade à incapacidade de ter uma conversa séria ou fazer novos amigos.

Este fenómeno não é novo; mas nunca foi tão iminente. E com a ubiquidade dos dispositivos digitais, a normalização do seu papel como mediadores das nossas interações e a crescente capacidade das máquinas — que hoje aparentam desempenhar com igual mestria o papel de médico, advogado, jornalista, chefe de cozinha ou de uma simples lista de compras —, pode estar a tornar-se numa alucinação colectiva com consequências imprevisíveis.

Entre anúncios pomposos e falhas clamorosas, o discurso em torno do potencial da IA continua inabalável e com contornos quase mitológicos. Mais do que como uma tecnologia limitada (como todas), e fruto de investimentos avultados (o que é), a IA surge como um avanço inevitável; e, ao mesmo tempo, desejável. Capaz de resolver o mundo e a nós próprios, ou tornar obsoleto quem não se adaptar. E com isso consolida-se culturalmente como uma criatura mitológica, com poderes sobreavaliados.

Tal como em muitos mitos religiosos, esta projecção espelha mais as nossas carências, ansiedades e desejos, do que concretiza qualquer facto objectivo. O que propicia um juízo de valor altamente especulativo. Os utilizadores não analisam o que está a acontecer, escolhem acreditar naquilo que vêm. Algo que se torna especialmente pernicioso quando uma das principais qualidades de aplicações de IA desta natureza é a sua capacidade para dar respostas plausíveis — independentemente da sua correção, autoridade ou apetência. Como demonstram os exemplos em diversos domínios: desde o estudo que demonstrou os problemas graves de citação em todos os principais modelos de IA, e a invenção de links falsos e autores inexistentes, aos terapeutas de IA que não só afirmam ter credenciais para a prática, como inventam números de licenças profissionais, créditos académicos e todo o tipo de artimanha para convencer o utilizador.

Num artigo de 1993 com o título sugestivo “Can Intelligence Be Artificial?”, o filósofo norte-americano Fred Dretske oferece-nos um ponto de partida revelador, através de uma analogia curiosa com peixes guppy e dinheiro: “Podemos pensar na inteligência como algo semelhante ao dinheiro — algo que quase toda a gente tem, mesmo que em quantidades diferentes. Ou então, podemos vê-la como riqueza — algo reservado a quem tem mais do que a média”. Enquanto a primeira definição contextualiza a inteligência como algo distribuído, plural e heterogéneo, a segunda convida a um olhar comparativo, se quisermos, até meritocrático – onde a valorização da diferença é preterida em prol da valorização da eficácia, da superação e da produtividade nas métricas estabelecidas. Segundo Dretske, os filósofos tendem a preferir a primeira definição, enquanto os engenheiros a segunda. E é sobre essa que se constrói boa parte do hype da Inteligência Artificial: não como uma inteligência que sabe jogar jogos, mas como a derradeira ferramenta para os vencer, mesmo que isso implique desrespeitar as regras ou abdicar de toda a diversão.

Explicada assim, esta distinção pode parecer abstracta ou demasiado teórica, mas se pensarmos nos discursos populares em torno das aplicações de inteligência rapidamente captamos a sua essência. E se pensarmos nas enormes lacunas na história social da IA, ainda mais rapidamente, fazemos ruir a carga mitológica desta tecnologia. Afinal de contas, a IA não é uma profecia inevitável, nem uma entidade super-poderosa, mas mais uma materialização de uma forma de ver a sociedade e a inteligência, em que o valor da pluralidade é preterido em detrimento de uma normatividade técnica. Ou seja, não é só um progresso tecnológico, como é um poderoso artefacto ideológico – que se dissemina através de um discurso acrítico, impulsionado por milhões e milhões de euros de investimentos.

Outro filósofo, o italiano Matteo Pasquinelli, publicou recentemente uma obra fundamental para dar resposta a esta questão. Em The Eye of the Master:A Social History of Artificial Intelligence, Pasquinelli traça a história da computação, desde o algarismo até aos algoritmos de aprendizagem automática e mostra-nos ligações que ficaram perdidas no tempo mas se revelam essenciais para compreender o que nos rodeia. Como a raíz comum entre este tipo de modelos e o neoliberalismo — Friedrich Hayek foi uma figura de destaque na história do conexionismo (corrente de de IA em que se baseiam os modelos de que falamos) — que nos pode ajudar a criar outra imagem desta tecnologia concorrente como a mitificação.

Simplificando, tal como a crença neoliberal sugere que dada a complexidade do mercado, com a criação de determinados mecanismos técnicos e o grau suficiente de concorrência e oferta, se atinge um ponto de auto-regulação; também a concepção dos modelos de IA se alimenta deste princípio. Neste caso, não para o aplicar ao mercado de bens e serviços, mas à informação. Sem recorrer a leis ou impostos, mas a algoritmos de optimização e melhores dados de treino.

Tanto num caso como noutro, este princípio ancora-se num ponto fundamental: de que o utilizador/consumidor é racional, atento e informado em todas as utilizações/escolhas. E se, voltando ao caso em apreço, isso é verdade em utilizações críticas da IA, não é compaginável com a exposição à tecnologia a que temos assistido, que leva desde os mais novos aos mais velhos a utilizações negligentes e abusivas destas ferramentas. E é aí que a Inteligência Artificial se torna anti-social.

A combinação entre a baixa literacia, grande investimento em marketing e relações públicas, e a apetência por design da tecnologia para emular diversos contextos pode ser explosiva. E os exemplos no capítulo são, mais do que casos isolados, evidências de um gesto que se vai tornando cada vez mais comum em todos os domínios da nossa vida. E que nos vai moldando colectivamente.

Se, no caso da saúde mental, a resposta da IA acelera na direção de individualizar os problemas e de prescrever soluções cada vez individualistas em vez de respostas sistémicas aos problemas, em quase todos os outros domínios, o sentido repete-se. A IA surge como uma forma de auto-contentamento fácil nas mais diversas materializações. Uma forma de dispensarmos o outro quer seja para estabelecermos conexões pessoais, ou para nos ligarmos ao mundo.

Do uso e abuso do ChatGPT ou do Grok nas nossas interações sociais, como forma de trazer novas informações, ajuizar a verdade, ou de garantir autoridade, até à Ghiblificação das nossas selfies, são inúmeras as instâncias em que utilizar a IA é percorrer um atalho onde não temos de nos cruzar com qualquer outro — nem connosco próprios. Uma forma de não termos de ler os artigos que alguém escreveu, nem termos de interpretar as informações que encontrámos. De não termos de nos esforçar para ter uma conversa séria (outro exemplo de Zuckerberg), nem conversarmos uns com os outros até chegar a uma ideia comum. De nem sequer termos de explicar a um artista o que queremos e ficar sujeitos à sua interpretação dos nossos desejos.

Muitos dos debates em torno destes epifenómenos, de resto, já reflectem em diferentes instâncias esta sensação de fragmentação social provocada por estes sistemas. Mas o hipotético potencial da IA, o seu valor especulativo, e a divisão da questão em domínios de especialidade (literacia mediática, direitos de autor), faz com que também o discurso se fragmente, poucas vezes se juntem todas as peças deste complexo puzzle, e se aponte o dedo a maus usos individuais em vez de reflectir sobre as consequências da pandemia de más utilizações de IA. Consequências essas que podem ser completamente novas, ou uma aceleração de problemas vigentes tão díspares quanto a precariedade laboral, a fabricação de artigos científicos para atingir métricas de produtividade, ou a inundação dos espaços públicos com desinformação e pós-verdade que torna impossível uma justa deliberação democrática.

Em dezembro do ano passado, um livro publicado por um filósofo de Hong Kong a viver em Berlim trouxe para a discussão um novo conceito. Em Hypnocracy: Trump, Musk, and the New Architecture of Reality, Jianwei Xun, propunha uma nova forma de ver o poder na era digital: não como algo que se impõe pela força ou coerção tradicional, mas como algo que nos induz num estado de hipnose coletiva, sustentado por narrativas emocionais, espetáculo mediático e a constante estimulação algorítmica. Segundo Xun, vivemos numa hipnocracia, um regime em que a atenção é a principal moeda de troca, e em que figuras como Trump ou Musk são protagonistas num teatro de ilusões contínuo, em que realidade e ficção se tornam indistinguíveis. Mas o melhor é que este autor não existe, nem nunca existiu.

Após o conceito ganhar tração, foi Sabina Minardi, editora da L’Espresso, que percebeu: o autor não existia. Todo a existência e rasto digital de Xun tinha sido fabricado por uma editora italiana. E o mestre do plano era Andrea Colamedici, um filósofo que aparecia nos créditos da versão italiana como tradutor e prontamente assumiu, não só a autoria, como a utilização de duas ferramentas de inteligência artificial.

Em entrevista à publicação norte-americana Wired, Colamedici que é professor de prompt thinking no European Institute of Design, e líder de um departamento de investigação em IA na Universidade de Foggia, revelou que a primeira motivação para escrever o livro foi ver os seus alunos a usar o ChatGPT. Mas não pelos bons motivos: “Apercebi-me de que estavam a utilizar o ChatGPT da pior forma possível: para o copiar. Observei que estavam a perder uma compreensão da vida ao confiarem na IA, o que é alarmante, porque vivemos numa era em que temos acesso a um oceano de conhecimento, mas não sabemos o que fazer com ele.”

A sua observação era de uma mudança tão profunda e com consequências tão vastas que não bastava escrever um tutorial. Colamedici escreveu um livro coerente, com um conceito válido e bastante útil, mas fez do próprio lançamento uma experiência filosófica. Recheado de pistas que mais tarde revelara — como o facto do primeiro capítulo ser precisamente sobre uma experiência semelhante em que um grupo de pessoas cria um autor falso — esta manobra pretendia ser, na prática, uma provocação sobre a apatia cognitiva, a perda da curiosidade e a incapacidade de interpretar os sinais para além das narrativas óbvias. E a menção a Trump ou Musk não é performativa, nem o conceito criado: “Basta ver o vídeo de Trump sobre Gaza – gerado por IA – ou as provocações de figuras como Musk. Sem ferramentas conceptuais sólidas, estamos a naufragar.”

Para Colamedici, Hypnocracy é uma demonstração prática de como cada vez mais criamos “as nossas próprias narrativas” e um alerta sobre a necessidade de as criar com consciência crítica, em vez de simplesmente consumir aquelas que nos são servidas por algoritmos, influencers ou máquinas. E simultaneamente um contributo para a conceptualização deste fenómeno. Ao inventar uma figura intelectual com credibilidade aparente, Colamedici colocou o espelho à frente de um sistema cultural. Assim, o livro não é apenas uma crítica aos mecanismos tecnológicos da era digital, mas também à nossa permeabilidade — enquanto sociedade — para acreditar sem questionar, para seguir sem verificar, para consumir sem digerir. Ou, nas palavras do autor, que podemos ler no seu site — um ensaio sobre a fragmentação da atenção e a saturação da informação como técnicas de indução hipnótica; a transformação do tempo num eterno presente algorítmico; a dissolução da identidade em múltiplas performances optimizadas para diferentes plataformas; e a gamificação da resistência e a absorção de todas as formas de oposição.

A forma de o conceber é um exemplo de que mais do que rejeitar a IA, podemos apropriá-la e utilizá-la de forma crítica: “É assim que devemos utilizar a IA: como um interlocutor que nos ajuda a pensar de forma diferente. Caso contrário, não compreenderemos que estas ferramentas são concebidas por grandes empresas tecnológicas que impõem uma determinada ideologia. Escolhem os dados, as ligações entre eles e, acima de tudo, tratam-nos como clientes a satisfazer. Se utilizarmos a IA desta forma, ela apenas confirmará os nossos preconceitos. Pensaremos que temos razão, mas, na realidade, não estaremos a pensar; estaremos a ser abraçados digitalmente. Não nos podemos dar ao luxo de ficarmos adormecidos.”

Neste sentido, Hypnocracy funciona como uma síntese perfeita do próprio estado da Inteligência Artificial nas nossas vidas: uma presença hipnótica, sedutora e plausível, que se infiltra nas nossas formas de saber, comunicar e até de sentir, sem que nos apercebamos do quanto nos molda — e sem termos hipótese de a moldar de forma que nos enriqueça. A analogia com a proposta de Zuckerberg, as constantes menções ao Grok ou os falsos terapeutas da Meta é simples: ao sugerir que a IA pode substituir amizades, relações ou conversas profundas, informação de qualidade, estamos precisamente a caminhar rumo a uma realidade onde a simulação toma o lugar da experiência real, e onde o conforto de uma resposta artificial se sobrepõe à complexidade e à curiosidade do encontro humano. A IA não nos torna anti-sociais porque nos isola à força, mas porque nos oferece alternativas suficientemente convincentes à presença do outro. E um atalho para interagir com o mundo sem estarmos presentes em nós próprios.

Como resume Colamedici de forma brilhante: “O que é que interessa se alguém desenhar melhor do que eu? Isso não é o mais importante. O que importa é que posso aprender a desenhar melhor e melhorar as minhas capacidades – trabalhando com IA ou com outra pessoa (recomendo com pessoas, mas se escolher IA, não há problema). tudo bem). O grande problema da humanidade é esta obsessão de ser o primeiro, de ser o centro da história. Mas a ciência já nos mostrou no século XIX que nós não estamos no centro do universo; estamos num canto remoto da Via Láctea. Via Láctea. Nem sequer somos o centro da vida na Terra: mais de 99% da biomassa é constituída por plantas, árvores e outras formas de vida. Somos tão pequenos e estamos cá há muito pouco tempo há muito pouco tempo, apenas 200.000 anos.”

O João Gabriel Ribeiro é co-fundador e editor do Shifter. É auto-didacta obsessivo e procura as raízes de temas de interesse como design, tecnologia e novos media.

Ver todos os artigosApoia a partir de 2€/mês, recebe uma newsletter exclusiva, acesso a descontos e passatempos, e contribui para mais textos como este.

Outros artigos de que podes gostar: