Discretamente, o YouTube é uma das plataformas mais aditivas. Os seus algoritmos de recomendação puxam para a página inicial vídeos com base no nosso histórico de visualização – ou seja, quer espreites conteúdo de um determinado youtuber por curiosidade, quer comeces a ver vídeos sobre um assunto específico, depressa o YouTube te vai sugerir mais desses criadores e desses temas, tornando-se difícil saíres dessa bolha. Por mais conteúdo diversificado que o YouTube tenha e que possa despertar-te novos interesses, não será esse que te vai aparecer.

Mas o lado aditivo não é o único problema do algoritmo de recomendação do YouTube. Este pode ter implicações sociais e políticas graves.

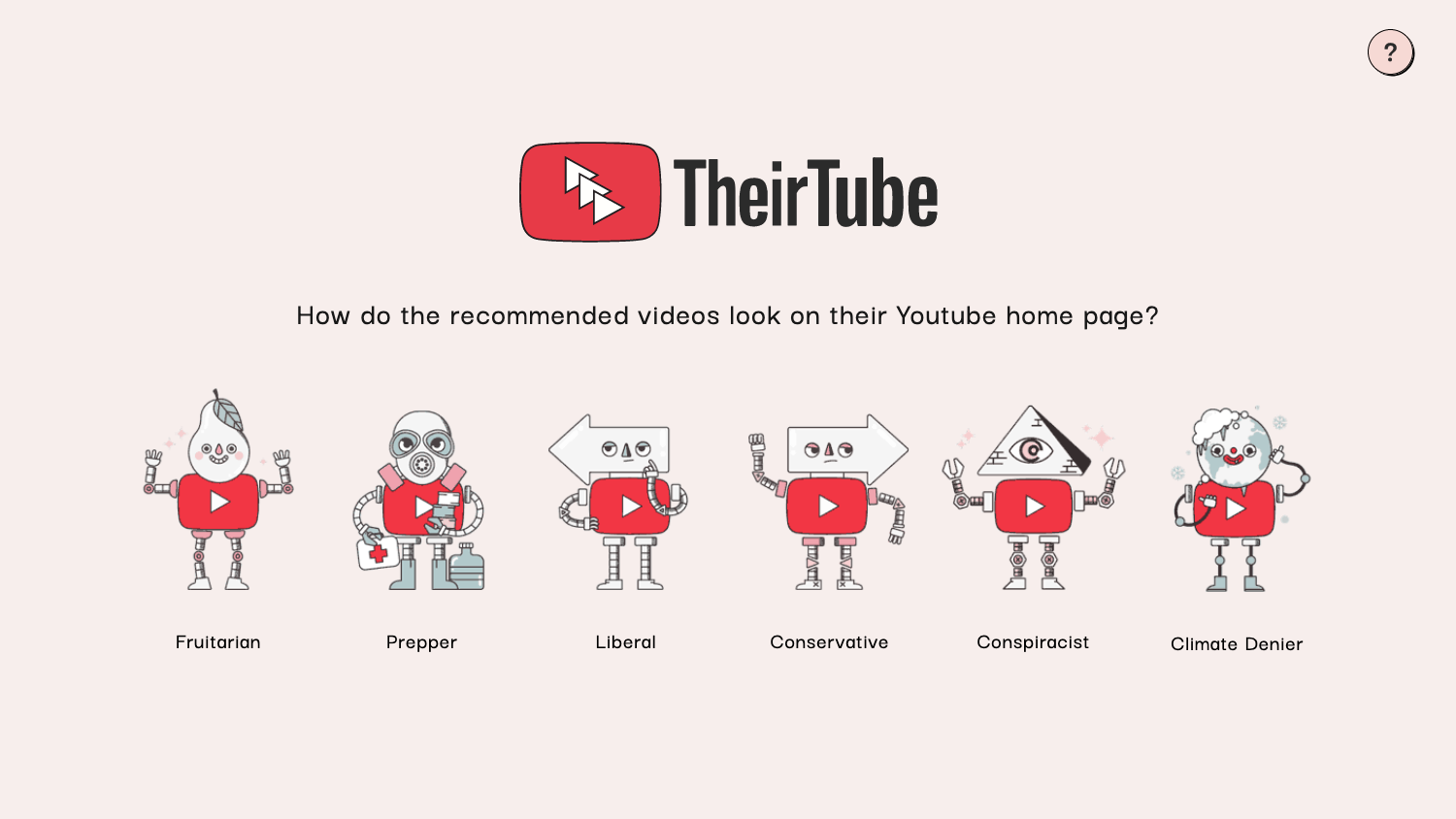

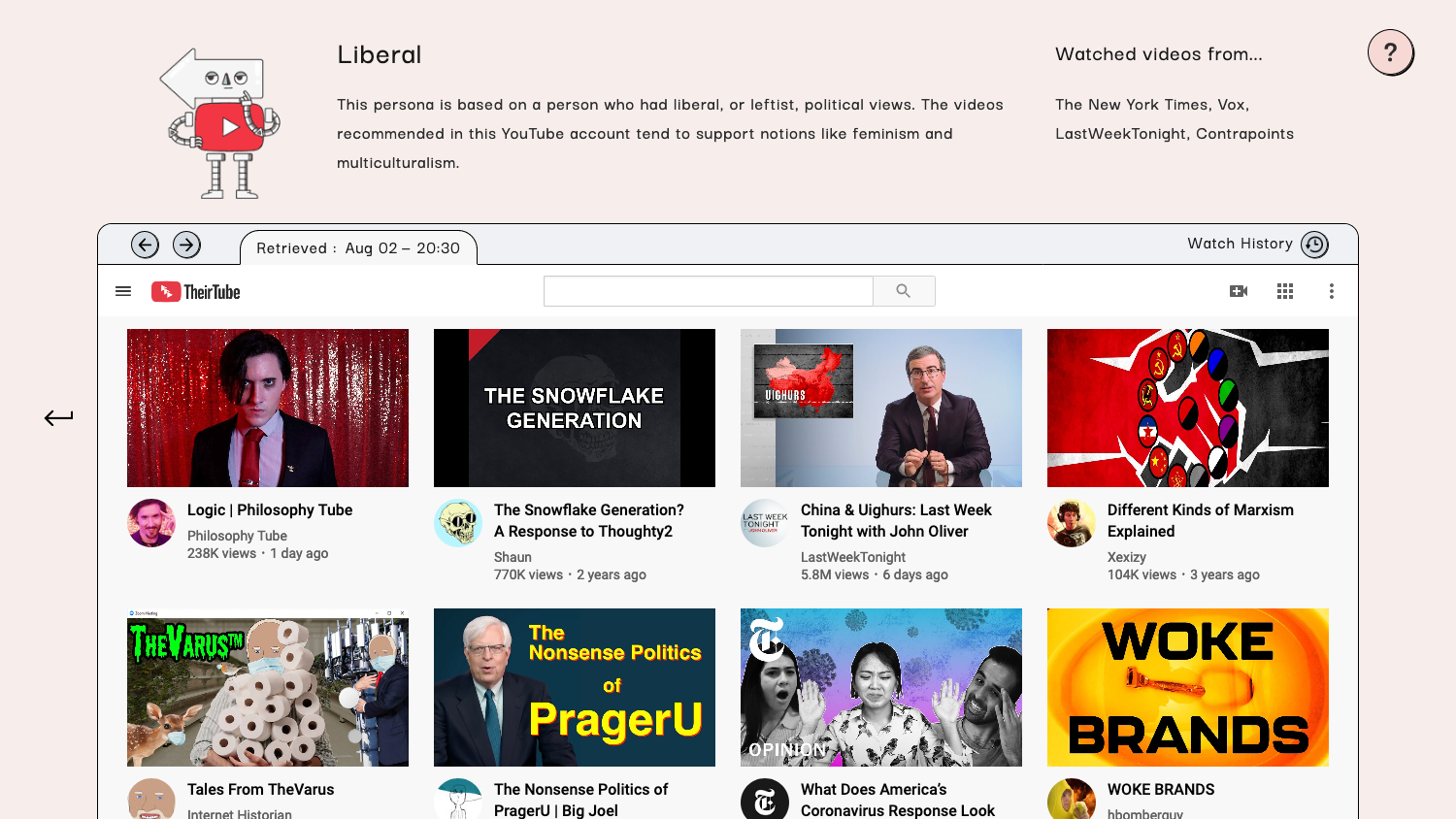

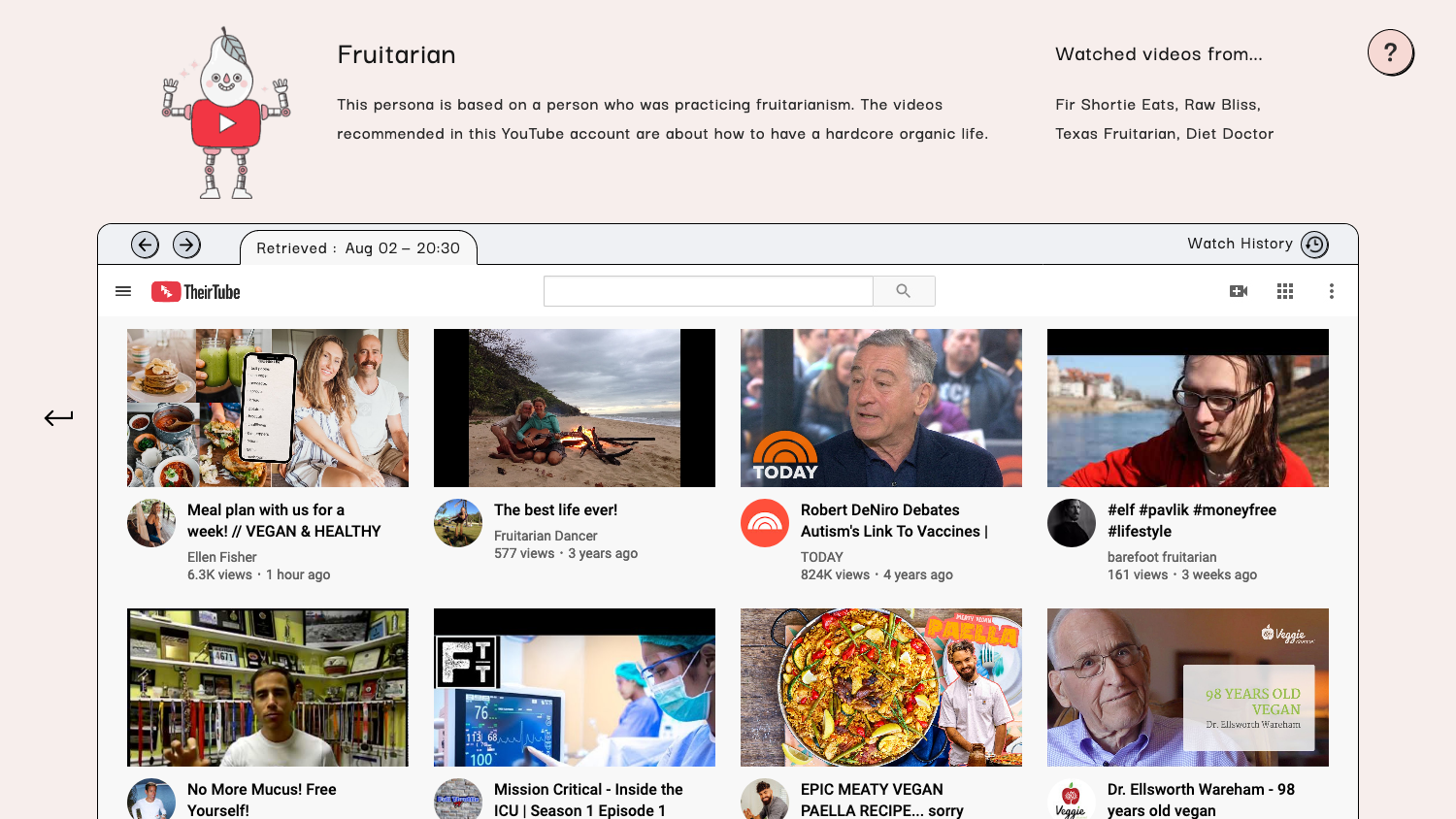

TheirTube é um site criado pelo programador Tomo Kihara com um fundo da Mozilla, que procura quebrar estas bolhas do YouTube que se formam para cada um de nós. O portal, que tem um design e um conceito bastante apelativos, simula recomendações com conteúdos reais do YouTube para seis tipos de perfil diferentes: Frutariano (pessoas que praticam o frutarianismo, isto é, uma dieta baseada em fruta), Prepper (pessoa que acredita que uma guerra ou desastre está próxima), Liberal (que tem visões políticas liberais), Conservador (que tem opiniões políticas conservadoras), Conspiracionista (para quem é adepto de teorias da conspiração) e Negacionista Climático (aquele que acredita que as alterações climáticas são uma farsa).

De acordo com Tomo Kihara, os seis perfis foram criados a partir de informações recolhidas em entrevistas dos utilizadores do YouTube que se viram confrontadas com as suas próprias bolhas, e os vídeos mostrados no TheirTube foram retirados aleatoriamente dos canais que essas pessoas seguiam. “O algoritmo de recomendação do YouTube responde por 70% de todos os vídeos vistos na plataforma, e embora seja útil, também pode mostrar os mesmos pontos de vista repetidamente, amplificando as opiniões que tu já tens. Isso às vezes pode levar pessoas a ter ideias ou crenças radicais”, disse Tomo Kihara no Twitter.

YouTube's recommendation algorithm accounts for 70% of all views on the platform, and while it is useful, it can show the same points of view over and over again, confirming and amplifying your existing bias. This sometimes can lead people to have radical beliefs and ideas ( 2 ) pic.twitter.com/CoNmpy7yok

— Tomo (@TomoKihara) July 16, 2020

O YouTube tem vindo a ser acusado de promover, por meio do seu algoritmo, conteúdos com visões extremistas que levam à radicalização de alguns dos seus utilizadores, sobretudo conspiracionistas ou de extrema-direita – nos EUA, os algoritmos podem ter contribuído para o crescimento da chamada alt-right. O YouTube está atento ao problema e disse estar a tentar resolvê-lo. Até lá, temos o TheirTube!

O Shifter é uma revista comunitária de pensamento interseccional. O Shifter é uma revista de reflexão e crítica sobre tecnologia, sociedade e cultura, criada em comunidade e apoiada por quem a lê.

Apoia a partir de 2€/mês, recebe uma newsletter exclusiva, acesso a descontos e passatempos, e contribui para mais textos como este.

Outros artigos de que podes gostar:

You must be logged in to post a comment.